微調整テクニックでGPT 4.xのポテンシャルを最大限に引き出す

この記事では、GPT 4.xの真の可能性を探り、その先進的なパワーと、特定のアプリケーションに適したモデルにするための微調整の重要な役割を強調する。

シリーズ全体を読む

- 非構造化データ入門

- ベクトルデータベースとは?その仕組みとは?

- ベクトルデータベースについて: ベクトルデータベース、ベクトル検索ライブラリ、とベクトル検索プラグインの比較

- Milvusベクトルデータベース入門

- Milvus Quickstart:五分間だけでMilvus ベクトルデータベースをインストール

- ベクトル類似検索入門

- ベクター・インデックスの基本について知っておくべきすべてのこと

- スカラー量子化と積量子化

- 階層的航行可能小世界(HNSW)

- おおよその最近接者 ああ(迷惑)

- プロジェクトに適したベクトルインデックスの選択

- DiskANNとヴァマナアルゴリズム

- データの完全性を守る:ベクターデータベースにおけるバックアップとリカバリ

- AIにおける高密度ベクトル:機械学習におけるデータの可能性の最大化

- ベクターデータベースとクラウドコンピューティングの統合:現代のデータ課題に対する戦略的ソリューション

- 初心者のためのベクターデータベース導入ガイド

- ベクトル・データベースにおけるデータの完全性の維持

- 行と列からベクトルへ:データベース技術の進化の旅

- ソフトマックス活性化関数の解読

- ベクトル・データベースにおけるメモリ効率のための積量子化の利用

- ベクターデータベースにおける検索性能のボトルネックを発見する方法

- ベクターデータベースの高可用性の確保

- Locality Sensitive Hashingのマスター:包括的なチュートリアルと使用例

- ベクターライブラリ vs ベクターデータベース:どちらが適しているか?

- 微調整テクニックでGPT 4.xのポテンシャルを最大限に引き出す

- マルチクラウド環境におけるベクターデータベースの展開

- ベクトル埋め込み入門:ベクトル埋め込みとは何か?

#はじめに

LLMは、人間のようなテキストを処理・生成するために設計された先進的なAIシステムであり、自然言語処理タスクに革命をもたらす。AIの世界では、GPT 4.xは画期的なLLMとなっている。OpenAIによって開発されたGPT(Generative Pre-trained Transformer)のこの特別なバージョンは、言語に対する驚異的な理解力を持ち、様々なタスクで多目的に使用できる。GPT 4.xは、複数の課題を処理する際に、AI業界において貴重な資産となることが証明されている。この記事では、GPT 4.xのパフォーマンスをさらに向上させることができる高度なテクニックの1つについて説明します。そのテクニックは、ファインチューニングとして知られています。ファインチューニングされたGPT-4モデルを使えば、コンテンツ生成から顧客サービスの自動化まで、幅広い課題に対応するAIアプリケーションを開発することができます。特定のアプリケーションに合わせてモデルをカスタマイズすることができます。OpenAIのGPTシリーズ、特にGPT-4はAIの進歩の頂点に立ち、驚くべき言語理解力と多様性を示しています。あなたのソフトウェアにAIを統合したい開発者であれ、最新のトレンドに興味がある人であれ、これらの微調整モデルはあなたをカバーしています。

GPT4.xを理解する

GPT 4.xは、Generative Pre-trained Transformerシリーズの亜種で、AI領域、特にNLP(自然言語処理)において驚異とされている。この最先端のモデルは、深層学習アーキテクチャに基づいて構築されており、ニューラルネットワークの層を活用して、入力に基づいて人間のような応答を模倣するテキストを理解し、生成する。GPT 4.xは、GPT 3.5を含む前世代のGPTを凌駕し、言語コンテキストの知識を強化しています。これにより、GPT 4.xは、よりニュアンスがあり、適切で、首尾一貫した応答を生成できるようになりました。これらの進歩は、洗練されたトレーニング技術、より大規模なデータセット、および基礎となるアーキテクチャの強化の統合の結果です。

微調整プロセスの理解

微調整とは一体何だろうか?AIやMLにおいてファインチューニングとは、事前に訓練されたモデルを調整し、特定のタスクのエキスパートにすることを指す。ファインチューニングの目的は、最初のトレーニングで獲得したモデルの広範な知識を洗練させ、よりよく理解し、専門的なタスクのためのテキストを生成することです。

GPT4のファインチューニング方法

ファインチューニングはGPT-4のカスタマイズを容易にし、特定のユースケースや要求に合わせてその機能を適応させることを可能にします。GPT4.xのファインチューニングにはいくつかのステップがあります。

**データの準備

まず、タスクに特化したデータセットをキュレートする必要があります。このデータセットは、入力データと希望する出力の例を含む、モデルが生成するコンテンツのタイプを表すものでなければなりません。

**モデルの選択

GPT 4.xを単一のモデルと考えるのは間違いではない。しかし、様々なサイズと構成があります。計算効率と性能のバランスが取れた適切なバージョンのモデルを選択してください。

**トレーニング環境のセットアップ

このような大規模で洗練されたモデルのトレーニング環境を準備するには、計算リソースが必要です。環境のセットアップには、ハードウェアとソフトウェアの構成、適切な機械学習フレームワーク、高速計算のためのGPUなどが含まれます。

**ファインチューニングの実行

データの準備と環境のセットアップが成功した後、ファインチューニングのプロセスを開始することができる。このプロセスでは、特化したデータセットでモデルを学習させ、モデルによる効率的な学習を保証するために学習率パラメータを調整する。検証を通じてモデルのパフォーマンスを監視することで、最良の結果を得ることができます。これらのステップをすべて踏むことで、GPT 4.xを特定のタスクに秀でるように微調整することができます。このアプローチにより、GPT 4.xはAIの世界でさらに強力なツールとなります。

効果的な微調整のテクニック

ファインチューニングされたモデルを効果的かつ効率的に動作させたいのであれば、以下のような点に注目しましょう。

**データキュレーション

データのキュレーションは、モデルのアウトプットに直接影響するため、LLMを微調整する際に最も重要な側面です。自動化されたデータキュレーションアプローチである CLEAR (Confidence-based LLM Evaluation and Rectification)は、どのような言語モデルやファインチューニング手順にも使用できる、インストラクションチューニングデータセットのためのパイプラインです。このパイプラインは、低品質のトレーニングデータを識別し、LLM由来の信頼度を使用して修正またはフィルタリングします。CLEARは、追加のファインチューニング計算を伴わずにデータセットとトレーニング済みモデルの出力を改善するフレームワークと考えられています。NVIDIA、Lilac、NeMo Data Curatorなどのツールが、より優れたデータパイプラインのために市場に登場した。

**パラメータ調整

微調整プロセスの2番目に重要な点は、パラメータ調整である。これは、GPT-4のようなLLMのポテンシャルを特定のドメインやタスクに対して最大化するために不可欠です。バッチサイズ、学習率、その他のハイパーパラメータのようなパラメータは、モデルの性能を最適化するために調整されなければなりません。最初に議論すべきは学習率で、これは新しいデータセットが入力されたときに、モデルの知識がどの程度調整されるかを決定します。最適な学習をオーバーシュートしたり、学習が遅すぎたりしないような学習レートを見つける必要がある。これはメモリの使用率に直接影響し、モデルの汎化能力に影響を与える。タスクに最適な設定を見つけるために、これらのパラメーターを実験する必要がある。例えば、PEFT(Parameter Efficient Fine-Tuning)は、更新が必要な学習パラメータの数を減らすための多くの方法を提供しています。部分的な微調整では、ニューラルネットワークの外側の層のみを更新します。これは、新しいタスクが元のタスクと類似性が高い場合に有効な戦略である。一方、加法的ファインチューニングは、モデルに余分なパラメー タを追加するが、新しい構成要素のみをトレーニングする。これにより、事前に訓練された元の重みは変更されない。

トレーニング戦略

それでは、いくつかのトレーニング戦略について説明しよう。1つ目は漸進的凍結解除で、モデルのレイヤーの凍結を上から徐々に解除していく。これにより、ニュアンス学習が増加し、モデルが以前に学習した情報を忘れてしまうのを防ぐことができる。モデルのすべての部分が同じペースで学習するわけではないので、モデルの層によって学習速度が異なるかもしれない。

モニタリングと評価

最後に、モニタリングと評価である。モデルの進捗をモニターし、メトリクスを使って評価することは本当に重要です。精度、損失曲線、リコール、特定のベンチマーク、指定されたタスクに関連する精度などのツールやメトリクスは、モデルの学習効率に関する洞察を提供することができます。

ファインチューニングされたGPT-4の実用例

ファインチューニングされたGPT 4.xは、多くの実用的なアプリケーションを持っています。コンテンツ作成に関しては、ファインチューニングされたGPT 4.xは、数学のステップワイズ解を生成することができ、より首尾一貫した正確な回答を生成します。例えば、ある開発者が数学の学習プラットフォームに取り組んでいる場合、GPT 4.xを微調整することで、大量の数学問題に対して段階的な解答を生成することができます。

顧客サービスでは、GPT4.xモデルを微調整することで、画像やテキストの文脈を理解し、顧客からの問い合わせにより正確な回答を提供することができます。例えば、ホームデコール会社では、テキストや画像から顧客の要求を理解するために、GPT 4.xモデルを使用することができます。

現在、コーディングにおいて、微調整されたGPT 4.xは、コードスニペットを生成するために使用することができます。開発時間が短縮され、コーディング効率が向上します。

医療診断:GPT-4を医学文献や患者記録で微調整することで、医療専門家がより正確な診断や治療勧告を行うことができます。

財務分析:GPT-4を金融データと市場動向で微調整することで、金融アナリストがより多くの情報に基づいた投資判断を下すのに役立ちます。

法律研究:GPT-4 を判例や法令にファインチューニングすることで、法律専門家がより効率的に判例を調査・分析することができます。

ケーススタディ

あるインテリア専門企業は、GPT 4.xモデルを微調整し、テキストと画像に基づいて顧客の嗜好を理解。顧客エンゲージメントを約40%向上させ、売上を20%改善。

同様に、あるソフトウェア開発会社は、GPT 4.xを微調整して、指定したプログラミングタスクのコードスニペットを生成しています。これらのケーススタディは、ファインチューニングがビジネスの成果とモデルのパフォーマンスに与える重要性と影響を証明している。

ファインチューニングにおける課題の克服

LLMのファインチューニングにおける一般的な課題と、それを克服するための戦略をご紹介します:

限られたタスク固有データ:ファインチューニングにはタスクに特化したデータセットが必要であり、特定のドメインにおいて十分に大規模で多様なデータセットを取得するには数ヶ月を要することがある。これを克服するには、データ増強、転移学習、ドメイン固有データとより一般的な言語データとのバランスなどの戦略](https://www.appypie.com/blog/challenges-fine-tuning-llm)の使用を検討する。

データ不足とドメインのミスマッチ:多くの状況において、特定のタスクやドメインのための広範なデータセットを入手することは困難である。モデルが事前に訓練されたデータと、微調整に必要なタスク固有のデータとのミスマッチは、重大な課題となる。これを克服するには、データ増強、転移学習、ドメイン固有データとより一般的な言語データとのバランスといった戦略の使用を検討する。

3)壊滅的な忘却:LLMを微調整すると、モデルが以前得意だったタスクの能力を失う可能性がある。この課題に対処するためには、正則化、知識の抽出、タスクの順序付けなどのテクニックを使用して、事前学習で得た知識を保持しながら、微調整の過程でモデルの能力が向上するようにする必要がある。

オーバーフィッティング:LLMのファインチューニングでは、モデルが学習データに特化しすぎてしまうオーバーフィッティングがよく見られます。この問題に対処するには、正則化戦略、交差検証、早期停止、アンサンブル学習、モデルの複雑性の監視を採用する。

バイアス: 訓練データに明示的または暗黙的なバイアスがある場合、微調整されたLLMによって生成される応答にそれが現れる可能性がある。この課題に対処するためには、バイアスを減らすためのトレーニングデータの前処理と、モデルの出力をデビアスするための後処理技術を含む、多方面からのアプローチを使用する。ファインチューニングされたモデルの動作を定期的に監査することも、偏った反応を特定し修正するのに役立ちます。

ハイパーパラメータのチューニング:不適切なハイパーパラメータを選択すると、収束が遅くなったり、汎化が悪くなったり、あるいは学習が不安定になったりすることがあります。この課題を克服するには、グリッドサーチやベイズ最適化などの技術を使用してハイパーパラメータのチューニングを自動化し、学習率のスケジュール、バッチサイズの実験、転移学習、クロスバリデーションなどを検討します**。

要約

この記事では、GPT 4.x の真の可能性を探り、その高度なパワーと、モデルを特定のアプリケー ションに適したものにするための微調整の重要な役割に焦点を当てました。ファインチューニングは、パラメーターの調整、データのキュレーション、厳密な評価、戦略的なトレーニングを通じて、GPT 4.x のパフォーマンスを効果的に向上させます。ファインチューニングの技術が進化すれば、GPT 4.xの潜在能力を最大限に引き出す上で、より重要な役割を果たすことになるでしょう。

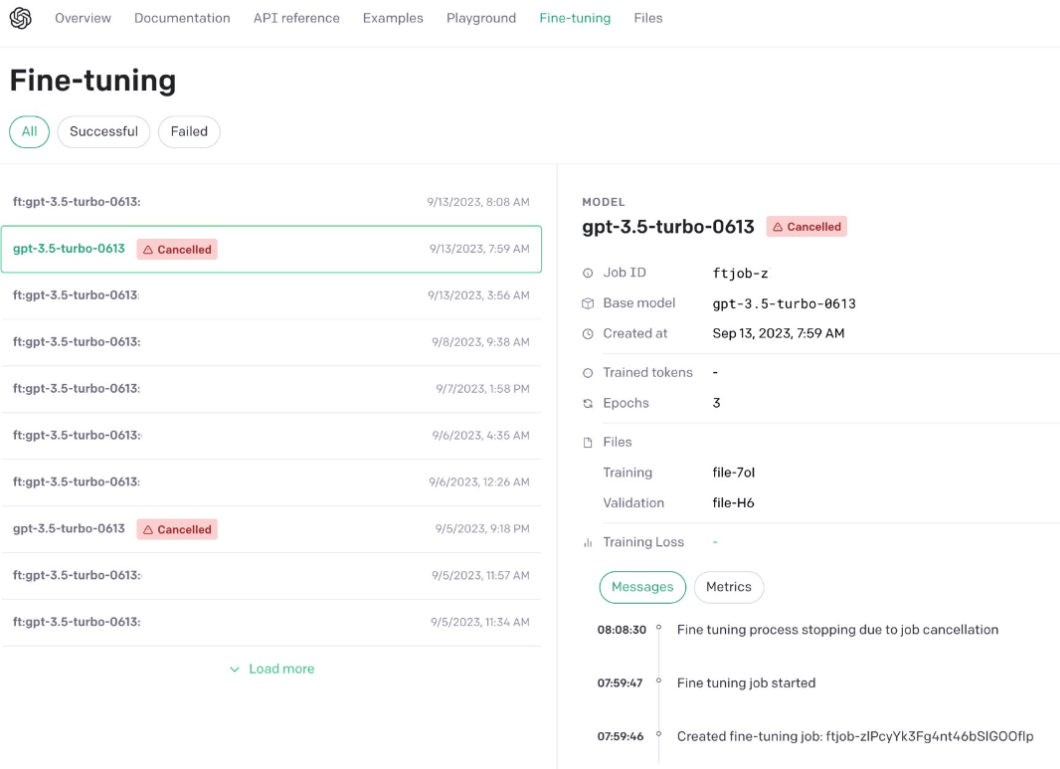

クレジットスーパーシンプル

微調整2.png

クレジットOpenAI Via Twitter

微調整2.png

クレジットOpenAI Via Twitter

読み続けて

非構造化データ入門

ベクトルデータベース101シリーズの最初のチュートリアルを始めましょう。毎週の学習につれて、複雑なMilvusも明白になっていきます。

ベクトルデータベースとは?その仕組みとは?

ベクトルデータベースは、高速な情報検索と類似検索のために、機械学習モデルによって生成されたベクトル埋め込みを保存し、インデックス作成し、検索を行うものです。本記事では、ベクトルデータベースの仕組み、主な特徴とユースケース、およびエコシステムについて説明します。

ベクトル・データベースにおけるデータの完全性の維持

データのライフサイクルを通じて、データが正しく、一貫性があり、信頼できることを保証することは、データ管理、特にベクターデータベースにおいて重要である。