2025年、開発者が無視できないオープンソースLLMフレームワーク10選

2024年は大規模言語モデル(LLM)にとって飛躍の年となったが、2025年に入ってもその勢いは衰える気配がない。GPT-4やGeminiのマルチモーダル機能からリアルタイム適応型AIシステムまで、LLMはもはや最先端というだけでなく、必要不可欠なものとなっている。LLMは、チャットボット、検索エンジン、コンテンツ作成ツール、さらにはかつて人間しか扱えないと考えられていたワークフローの自動化にまで力を発揮している。

しかし、強力なLLMを持つことは、戦いの半分に過ぎない。スケーラブルで、効率的で、本番環境にも対応できるLLMアプリケーションを構築するのは困難です。LLMフレームワークは、ワークフローを簡素化し、パフォーマンスを向上させ、既存システムとシームレスに統合することで、開発者が少ない労力でLLMモデルの可能性を最大限に引き出せるよう支援します。

この記事では、AI開発者が2025年に向けて無視できない、オープンソースのLLMフレームワークを10個紹介する。これらのフレームワークは、開発者がこれまで以上に迅速にスケールし、最適化し、イノベーションを起こすための秘密兵器だ。AIプロジェクトをレベルアップさせる準備ができているなら、さっそく飛び込もう!

LangChain:コンテキストを考慮したマルチステップAIワークフローを実現する

LangChainは、大規模言語モデル(LLM)を利用したアプリケーションの開発を効率化するために設計されたオープンソースのフレームワークです。LLMと外部データソース、API、または計算ロジックを組み合わせたワークフローの構築を簡素化し、開発者が会話エージェント、文書分析、要約などのタスクのための動的でコンテキストを意識したシステムを作成できるようにします。

主な機能

コンポーザブル・パイプライン**:LangChainは、複数のLLMコールと外部関数を簡単に連鎖させ、複雑なマルチステップワークフローを可能にします。

既製のチェーン**:LangChainは、特定の高度なタスクを達成するために設計されたコンポーネントの組織化されたアセンブリである、構成済みのチェーンを提供します。これらの既製チェーンは、プロジェクトの開始を簡素化します。

プロンプトエンジニアリングユーティリティ**:特定のタスクに合わせたプロンプトを作成、管理、最適化するためのツールが含まれています。

メモリ管理:よりパーソナライズされたアプリケーションを可能にする、インタラクション全体にわたる会話のコンテキストを保持するための組み込み機能を提供します。

LangChainはサードパーティのAPI、ベクターデータベース、LLM、様々なデータソースと接続しています。特に、MilvusやZilliz Cloudのようなベクトルデータベースとの統合は、LangChainの可能性をさらに高めます。Milvusはオープンソースの高性能ベクトルデータベースで、10億スケールの埋め込みベクトルを管理・照会できます。LangChainの機能を補完し、関連データの高速かつ正確な検索を可能にします。開発者はこの統合を活用して、Milvusが文脈に関連した文書を検索するスケーラブルなRAG(Retrieval-Augmented Generation)システムを構築することができます。LangChainは、正確で洞察に満ちた出力を生成するために生成モデルを使用します。詳しくは以下のリソースをご覧ください:

言語パワーを解き放つ:LangChain入門 ](https://zilliz.com/learn/LangChain)

高度なRAGのためのLangChainとZillizクラウド統合](https://zilliz.com/product/integrations/langchain)

LangChainJS、Milvus、StrapiでRAGを構築する ](https://zilliz.com/blog/build-rag-with-langchain-milvus-and-strapi)

Milvus、LangChain、OpenAIで多言語RAGを構築する方法](https://zilliz.com/blog/building-multilingual-rag-milvus-langchain-openai)

LangChainによるNotion Docs上の検索拡張生成 ](https://zilliz.com/blog/retrieval-augmented-generation-on-notion-docs-via-langchain)

LlamaIndex:LLMと多様なデータソースをつなぐ

[LlamaIndex**](https://github.com/run-llama/llama_index)は、大規模言語モデル(LLM)が多様なデータソースに効率的にアクセスし、活用できるようにするオープンソースのフレームワークです。非構造化データの取り込み、構造化、クエリを簡素化し、文書検索、要約、知識ベースのチャットボットなどの高度なAIアプリケーションの構築を容易にします。

主な機能

データ・コネクター**:PDF、SQL データベース、API、ベクターストアなどの多様なソースから構造化データおよび非構造化データを取り込むための堅牢なコネクターセットを提供します。

インデックス作成ツールツリー構造、リスト構造、グラフ構造を含むカスタム・インデックスを作成し、データのクエリや検索を最適化できます。

クエリの最適化高度なクエリ・メカニズムを提供し、正確で文脈に関連した応答を可能にします。

拡張性**:高度にモジュール化されているため、外部ライブラリやツールとの統合が容易で、機能強化が図れます。

LLM最適化フレームワーク**:LLMと連携するように設計されているため、大規模タスクの計算リソースを効率的に利用できます。

LlamaIndexは、スケーラブルで効率的なRAGワークフローをサポートするために、MilvusやZilliz Cloudのような様々な専用のベクターデータベースと統合されています。このセットアップでは、Milvusが埋め込みベクトルの保存とクエリのための高性能バックエンドとして機能し、LlamaIndexがLLMが処理するために検索されたデータを構造化して整理します。この組み合わせにより、開発者は最も関連性の高いデータポイントを取得することができ、LLMはより正確で文脈を考慮した出力を提供することができます。詳細については、以下のリソースをご覧ください:

チュートリアル|** LlamaIndexを始めよう](https://zilliz.com/learn/getting-started-with-llamaindex)

ドキュメント|**Zilliz CloudとLlamaIndexを使ったドキュメントQA](https://zilliz.com/learn/milvus-notebooks)

ビデオ](https://www.youtube.com/watch?v=S4GmdrlqVKc)

LlamaIndex CEOジェリー・リュー氏とのビデオ|LlamaIndexを使用したプライベートデータでLLMを強化](https://zilliz.com/event/boost-your-llm-with-private-data-using-llamaindex)

Haystack:生産に適したAIアプリケーションのためのRAGパイプラインの合理化

Haystackは、LLMを搭載したアプリケーションの開発を容易にするために設計されたオープンソースのPythonフレームワークである。LLMを様々なデータソースやコンポーネントと統合することで、開発者はエンドツーエンドのAIソリューションを作成することができ、RAG、文書検索、質問応答、回答生成などのタスクに適しています。

主な機能

柔軟なパイプライン**:Haystack では、文書検索、質問応答、要約などのタスク用にモジュール化されたパイプラインを作成できます。開発者はさまざまなコンポーネントを組み合わせて、特定のニーズに合わせてワークフローをカスタマイズできます。

リトリーバー・リーダーアーキテクチャ**:効率的な文書フィルタリングのためのリトリーバーと、正確で文脈を意識した応答を生成するリーダー(LLMなど)を組み合わせます。

バックエンドにとらわれない**:MilvusやFAISSを含む複数のベクトルデータベースバックエンドをサポートし、柔軟な展開を保証。

LLMの統合**:言語モデルとのシームレスな統合を提供し、開発者は様々なタスクのために事前に訓練され、微調整されたモデルを活用することができます。

スケーラビリティとパフォーマンス大規模なデータセットと高スループットのクエリを処理するために最適化されており、エンタープライズ・アプリケーションに適しています。

2024年3月、HaystackはHaystack 2.0をリリースし、より柔軟でカスタマイズ可能なアーキテクチャを導入した。このアップデートにより、並列分岐やループなどの機能を備えた複雑なパイプラインの作成が可能になり、LLMやエージェント動作のサポートが強化された。新しい設計では、データを保存するための共通のインターフェイスが強調され、MilvusやZilliz Cloudを含む様々なデータベースやベクターストアとの統合が提供されます。この柔軟性により、Haystackパイプライン内でデータへのアクセスや管理が容易になり、スケーラブルで高性能なAIアプリケーションの開発をサポートします。詳細については、以下のリソースをご覧ください:

Haystack GitHub**:https://github.com/deepset-ai/haystack

統合**:HaystackとMilvus

チュートリアル:** MilvusとHaystackによる検索支援型生成(RAG)

チュートリアル:** MilvusとHaystack 2.0によるRAGパイプラインの構築

Dify:LLMによるアプリ開発の簡素化

Dify**は、AIアプリケーション構築のためのオープンソースプラットフォームです。Backend-as-a-ServiceとLLMOpsを組み合わせ、主流の言語モデルをサポートし、直感的なプロンプト・オーケストレーション・インターフェースを提供します。Difyは、高品質のRAGエンジン、柔軟なAIエージェントフレームワーク、直感的なローコードワークフローを提供し、開発者と非技術系ユーザーの両方が革新的なAIソリューションを作成できるようにします。

主な機能

LLM向けバックエンド・アズ・ア・サービス**:バックエンドのインフラを処理するため、開発者はサーバーの管理よりもアプリケーションの構築に専念できます。

プロンプト・オーケストレーション**:特定のタスクに合わせたプロンプトの作成、テスト、管理を簡素化します。

リアルタイム分析**:ワークフローを最適化するために、モデルのパフォーマンス、ユーザーインタラクション、アプリケーションの動作に関する洞察を提供します。

幅広い統合オプション**:サードパーティのAPI、外部ツール、一般的なLLMと接続し、カスタムワークフローの柔軟性を提供します。

DifyはMilvusのようなベクターデータベースとうまく統合し、複雑で大規模なデータ検索タスクを処理する能力を高めます。DifyをMilvusと組み合わせることで、開発者はRAGのようなタスクのための埋め込みデータを効率的に保存、検索、処理するシステムを作ることができます。

チュートリアルDifyとMilvusの組み合わせ

Dify ドキュメント](https://docs.dify.ai/)

Letta (Previous MemGPT): 拡張LLMコンテキストウィンドウを使用したRAGエージェントの構築

Lettaはオープンソースのフレームワークで、LLMに長期記憶を持たせることでLLMを強化するように設計されています。入力を静的に処理する従来のLLMとは異なり、Lettaはモデルが過去のやりとりを記憶し参照することを可能にし、より動的でコンテキストを意識した、パーソナライズされたアプリケーションを実現します。また、メモリ管理技術を統合することで、時間の経過とともに情報を保存、検索、更新することができるため、ユーザーとのインタラクションによって進化するインテリジェントエージェントや会話システムの作成に最適です。

図- Lettaと様々なAIツールとの連携](https://assets.zilliz.com/Figure_How_Letta_works_with_various_AI_tools_05d96d2548.png)

主な機能

自己編集メモリ:** Lettaは自己編集メモリを導入し、エージェントが自律的に知識ベースを更新し、相互作用から学び、時間と共に適応することを可能にします。

エージェント開発環境(ADE):** AI エージェントを作成、配置、対話、観察するためのグラフィカルなインターフェイスを提供し、開発とデバッグのプロセスを合理化します。

永続性と状態管理(Persistence and State Management):** エージェントが、記憶やインタラクションを含む状態を永続化することで、セッション間の連続性を維持し、より首尾一貫した、文脈に関連した応答を可能にします。

ツールの統合:*** エージェントが幅広いタスクを実行し、必要に応じて外部情報にアクセスできるように、カスタムツールとデータソースの組み込みをサポートします。

モデル非依存型アーキテクチャ:** 様々な LLM や RAG システムで動作するように設計されており、異なるモデルプロバイダーを柔軟に選択し統合することができます。

Lettaは主流のベクトルデータベースと統合し、高度なRAGワークフローのための記憶および検索機能を強化しています。スケーラブルなベクトルストレージと効率的な類似検索を活用することで、LettaはAIエージェントが長期的なコンテキスト知識にアクセスして保持することを可能にし、迅速かつ正確なデータ検索を保証します。この統合により、開発者は、永続的でスケーラブルなメモリを維持しながら、カスタマーサポートやパーソナライズされたレコメンデーションなど、特定のドメインに合わせた、よりスマートでコンテキストを意識したアプリケーションを構築することができます。詳細は以下のリソースをご覧ください。

- チュートリアル|MemGPTとMilvusの統合

Vanna: AIによるSQL生成を可能にする

VannaはオープンソースのPythonフレームワークで、自然言語入力によるSQLクエリの生成を簡素化するように設計されている。RAGテクニックを活用することで、Vannaはユーザが特定のデータでモデルを訓練することを可能にし、ユーザが質問を投げかけ、データベースに合わせた正確なSQLクエリを受け取ることを可能にする。このアプローチにより、データベースとの対話プロセスが合理化され、SQLの豊富な専門知識を持たないユーザでもアクセスしやすくなります。

Vanna](https://assets.zilliz.com/Vanna_7fe4f049f3.png)

主要能力

自然言語からSQLへの変換**:Vannaは、ユーザーが自然言語で質問を入力することを可能にし、それを接続されたデータベース上で実行可能な正確なSQLクエリに変換します。

複数のデータベースのサポート**:このフレームワークは、Snowflake、BigQuery、Postgresなど、様々なデータベースをすぐにサポートします。また、カスタムコネクタを通じて、あらゆるデータベースと簡単に統合できます。

ユーザーインターフェースの柔軟性**:Vannaは、Jupyter Notebooks、Slackbot、Webアプリ、Streamlitアプリなど複数のユーザーインターフェースオプションを提供し、ユーザーはワークフローに最も適したフロントエンドを選択できます。

Vannaとベクトル・データベースは、効果的なRAGシステムを構築するのに最適な組み合わせである。ユーザーが自然言語のクエリを入力すると、Vannaはベクトル・データベースを利用して、あらかじめ格納されたベクトル埋め込みに基づいて関連データを検索する。このデータは、Vannaが正確なSQLクエリを生成するために使用され、リレーショナル・データベースから構造化されたデータを簡単に取得することができます。ベクトル検索とSQL生成のパワーを組み合わせることで、Vannaは非構造化データでの作業を簡素化し、ユーザが高度なSQLの知識を必要とせずに複雑なデータセットを扱うことを可能にします。詳細については、以下のリソースをご覧ください:

チュートリアル:VannaとMilvusでSQLを書く

Milvus + Vanna: AIによるSQL生成](https://zilliz.com/product/integrations/vanna-ai)

Kotaemon:AIを活用したドキュメントQAの構築

Kotaemonは、ドキュメントとチャットするためのオープンソースでカスタマイズ可能なRAG UIです。kotaemonは、フルテキストとベクトル検索機能を備えたハイブリッドRAGパイプラインを提供し、図表を含む文書のマルチモーダルQAを可能にします。

エンドユーザーと開発者の両方のために設計されたkotaemonは、ReActやReWOOのような複雑な推論手法をサポートします。文書のプレビュー、検索と生成のための設定可能な高度な引用、カスタムRAGパイプラインを構築するための拡張可能なフレームワークを備えています。

Kotaemon

Kotaemon

キー機能

簡単なデプロイメント**:Kotaemonは最小限のセットアップで本番環境にLLMをデプロイするシンプルなインターフェースを提供し、迅速なスケーリングと統合を可能にします。

カスタマイズ可能なパイプライン**:LLMと外部API、データベース、その他のツールを組み合わせ、AIワークフローを簡単にカスタマイズすることができます。

高度なプロンプト**:プロンプトエンジニアリングと最適化のためのビルトインツールを備え、特定のタスクのためのモデル出力の微調整を容易にします。

パフォーマンスの最適化**:ハイパフォーマンスなオペレーションのために設計されたKotaemonは、低レイテンシーのレスポンスとリソースの効率的な使用を保証します。

マルチモデルサポート:フレームワークは様々なLLMアーキテクチャをサポートし、開発者に特定のユースケースに最適なモデルを選択する柔軟性を与えます。

KotaemonはMilvusのようなベクトルデータベースと統合し、RAG(Retrieval-Augmented Generation)のようなタスクのための関連データの高速検索を可能にします。Milvusの効率的なベクトル検索機能を活用することで、KotaemonはAIが生成したアウトプットのコンテキストと関連性を強化することができます。この統合により、開発者はコンテンツを生成し、大規模なデータセットから関連情報を取得するAIシステムを構築することができ、全体的なパフォーマンスと精度を向上させることができます。

Kotaemon RAG with Milvus|ドキュメント](https://milvus.io/docs/kotaemon_with_milvus.md)

Zilliz Cloud + Kotaemon: AIを活用したドキュメントQA](https://zilliz.com/product/integrations/kotaemon)

vLLM: リアルタイムAIアプリケーションのための高性能LLM推論

vLLMはUC BerkeleyのSkyLabによって開発されたオープンソースライブラリで、LLM推論とサービングを最適化するように設計されている。vLLMはパフォーマンスとスケーラビリティに重点を置き、PagedAttentionのような革新的な技術を導入しており、従来のアプローチと比較してGPUメモリの使用量を半分に削減しながら、処理速度を最大24倍まで向上させます。これにより、ハードウェア・リソースの効率的な利用を必要とする要求の厳しいAIアプリケーションを構築する開発者にとって、vLLMは画期的な製品となります。

主な機能

PagedAttentionテクノロジー: **アテンション・キーと値の非連続的な保存を可能にすることでメモリ管理を強化し、メモリの無駄を削減し、スループットを最大24倍向上させます。

連続バッチ処理:** GPU の使用率を最大化し、アイドル時間を最小化することで、より高いスループットと低レイテンシーを実現します。

ストリーミング出力:** リアルタイムのトークン生成を提供するため、アプリケーションは部分的な結果を即座に配信できます。

幅広いモデル互換性:** GPTやLLaMAのような一般的なLLMアーキテクチャをサポートし、多くのユースケースに対する柔軟性と既存のワークフローとのシームレスな統合を保証します。

OpenAI互換APIサーバー:** OpenAIのAPIを反映したAPIインターフェイスを提供し、OpenAIのAPIに精通した開発者の既存システムへの導入と統合を簡素化します。

vLLMは、Milvusのようなベクトルデータベースと組み合わせることで、高性能なRAGシステムを構築するための基礎となる。vLLMは最適化されたLLM推論を提供することでこれを補完し、検索された情報がシームレスに処理され、正確でコンテキストを認識した応答が得られることを保証します。この統合により、アプリケーションのパフォーマンスが向上し、検索されたデータに基づいた出力を行うことで、AIの幻覚のような課題に対処することができます。詳細は以下のリソースをご覧ください。

vLLMとMilvusによるマルチモーダルRAGシステムの展開](https://zilliz.com/blog/deploy-multimodal-rag-using-vllm-and-milvus)

Milvus、Qwen、vLLMによるRAGアプリケーションの構築](https://zilliz.com/blog/build-rag-app-with-milvus-qwen-and-vllm)

PagedAttentionによる大規模言語モデルサービングの効率的なメモリ管理](https://zilliz.com/learn/efficient-memory-management-for-llm-serving-pagedattention)

Milvus、vLLM、Meta's Llama 3.1によるRAGの構築 ](https://zilliz.com/blog/building-rag-milvus-vllm-llama-3-1)

非構造化:非構造化データをGenAIのために利用可能にする

Unstructuredは、PDF、HTML、Word文書、画像など多様なデータ形式の非構造化データの取り込みと前処理を効率化するオープンソースライブラリである。ドキュメントの分割、クリーニング、抽出、ステージング、チャンキングのためのモジュール機能を提供し、非構造化データの構造化フォーマットへの変換を容易にします。このツールキットは、大規模言語モデル(LLM)アプリケーションにおけるデータワークフローの最適化に役立ちます。

UnstructuredをMilvusのようなベクトルデータベースと統合することで、AIアプリケーションで非構造化データを管理・活用するための強力でスケーラブルなソリューションが実現します。Unstructuredプラットフォームは、様々なファイルタイプの非構造化データを取り込み、処理し、AIに対応したベクトル埋め込みに変換します。これらのエンベッディングは、高度なAIワークフローにとって極めて重要であるが、それらを効果的に保存、インデックス付け、クエリするには、専用のベクトルデータベースが必要である。UnstructuredとMilvus(またはZilliz Cloud)の相乗効果により、合理化されたエンドツーエンドのパイプラインが可能になり、これは特にRAG(Retrieval-Augmented Generation)やスマートチャットボットやパーソナライズされたレコメンデーションシステムのような他のAI駆動型アプリケーションにとって価値がある。

非構造化](https://assets.zilliz.com/Unstructured_io_4a6cb7f228.png)

チュートリアル|MilvusとUnstructuredでRAGを構築する

Langfuse: LLMアプリケーションのためのより良い観測可能性と分析

LangfuseはオープンソースのLLMエンジニアリングプラットフォームであり、LLMアプリケーションの共同デバッグ、分析、反復作業を支援する。観測可能性、プロンプト管理、評価、メトリクスなどの機能がネイティブに統合されており、開発ワークフローを加速します。

主な機能

エンド・ツー・エンドの観察可能性**:プロンプト、応答、パフォーマンス・メトリクスを含む LLM インタラクションを追跡し、透明性と信頼性を確保します。

プロンプト管理**:プロンプトのバージョンアップ、最適化、テストを行うツールを提供し、堅牢なAIアプリケーションの開発を効率化します。

柔軟な統合**:LangChainやLlamaIndexのような一般的なフレームワークとシームレスに動作し、幅広いLLMアーキテクチャをサポートします。

リアルタイムデバッグ**:エラーやボトルネックに対する実用的な洞察を提供し、開発者が迅速に反復できるようにします。

Langfuseをベクターデータベースと統合することで、エンベッディングの品質と関連性を観察できるようになり、RAGワークフローが強化されます。この統合により、開発者は詳細な分析を通じてベクター検索のパフォーマンスと精度を監視・最適化することができ、検索プロセスが細かく調整され、ユーザーのニーズに合致していることを確認できます。まずは以下のチュートリアルをご覧ください。

- Langfuseを使ってRAGの品質を評価する](https://milvus.io/docs/integrate_with_langfuse.md)

結論

2025年が始まり、オープンソースのフレームワークがもはや単なる便利なアドオンではなく、堅牢なLLMアプリケーションを構築するための基礎となっていることは明らかだ。LangChainやLlamaIndexのようなフレームワークは、データの統合やクエリの方法を変え、vLLMやHaystackはスピードとスケーラビリティの新しいベンチマークを設定している。LangfuseやLettaのような新しいフレームワークは、観測可能性とメモリに独自の強みをもたらし、よりスマートで応答性の高いAIシステムへの扉を開きます。

これらのフレームワークにより、開発者は複雑な課題に取り組み、大胆なアイデアを試し、可能性の限界を押し広げることができます。これらのフレームワークがあなたの指先にあれば、2025年は、より賢く、より速く、よりインパクトのあるGenAIアプリケーションを構築する年です。

- LangChain:コンテキストを考慮したマルチステップAIワークフローを実現する

- LlamaIndex:LLMと多様なデータソースをつなぐ

- Haystack:生産に適したAIアプリケーションのためのRAGパイプラインの合理化

- Dify:LLMによるアプリ開発の簡素化

- Letta (Previous MemGPT): 拡張LLMコンテキストウィンドウを使用したRAGエージェントの構築

- Vanna: AIによるSQL生成を可能にする

- Kotaemon:AIを活用したドキュメントQAの構築

- vLLM: リアルタイムAIアプリケーションのための高性能LLM推論

- 非構造化:非構造化データをGenAIのために利用可能にする

- Langfuse: LLMアプリケーションのためのより良い観測可能性と分析

- 結論

コンテンツ

読み続けて

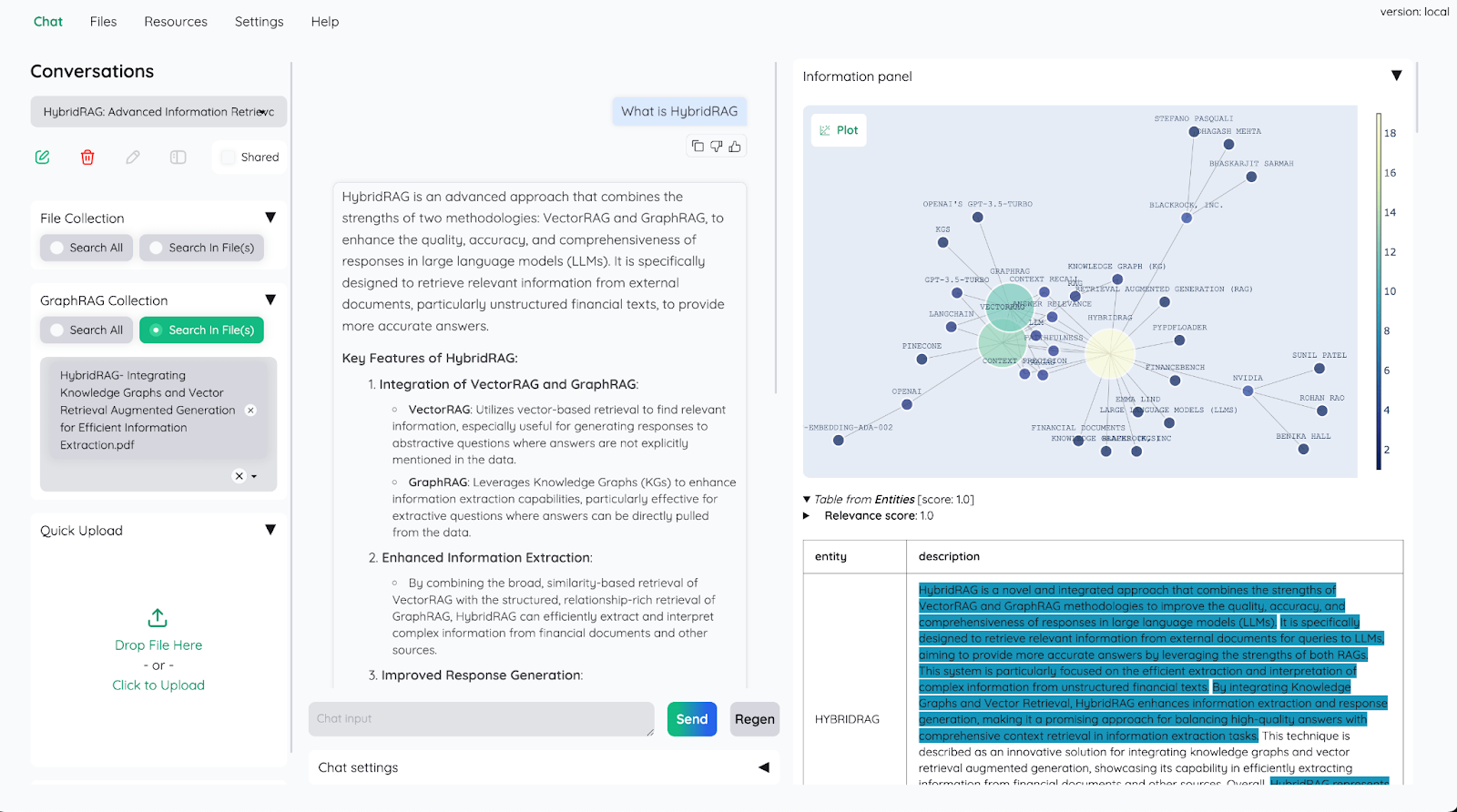

Producing Structured Outputs from LLMs with Constrained Sampling

Discuss the role of semantic search in processing unstructured data, how finite state machines enable reliable generation, and practical implementations using modern tools for structured outputs from LLMs.

Building Secure RAG Workflows with Chunk-Level Data Partitioning

Rob Quiros shared how integrating permissions and authorization into partitions can secure data at the chunk level, addressing privacy concerns.

Top 10 AI Agents to Watch in 2025 🚀

AI agents are like having a supercharged assistant by your side—analyzing data, making decisions, and seamlessly integrating with tools and environments.