OpenAIウィスパー高度なAIで音声をテキストに変換する

Open AI Whisperを理解し、このステップバイステップの記事に従ってプロジェクトに導入することで、音声テキスト化作業の効率を大幅に向上させることができます。

シリーズ全体を読む

- OpenAIのChatGPT

- GPT-4.0と大規模言語モデルの秘密を解き明かす

- 2024年のトップLLM:価値あるもののみ

- 大規模言語モデルと検索

- ファルコン180B大型言語モデル(LLM)の紹介

- OpenAIウィスパー高度なAIで音声をテキストに変換する

- OpenAI CLIPを探る:マルチモーダルAI学習の未来

- プライベートLLMとは?大規模言語モデルをプライベートで実行 - privateGPTとその先へ

- LLM-Eval:LLMの会話を評価するための合理的なアプローチ

- CohereのRerankerを使いこなし、AIのパフォーマンスを向上させる

- PagedAttentionを用いた大規模言語モデルサービングの効率的なメモリ管理

- LoRAの説明LLMを微調整するための低ランク適応

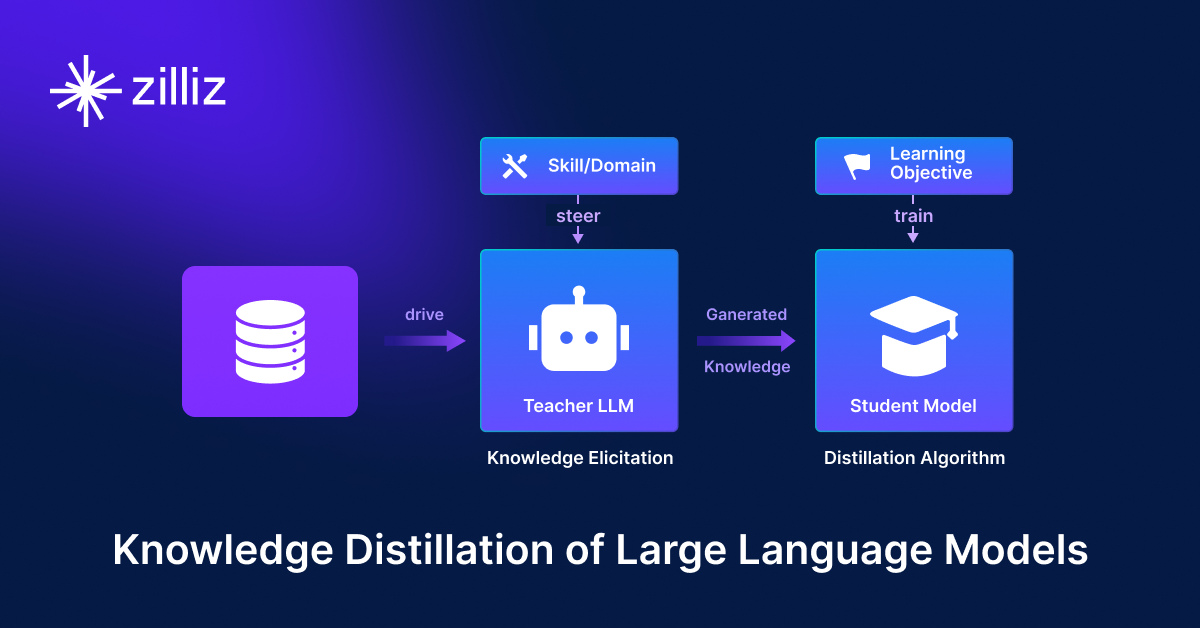

- 知識の蒸留:妥当性を犠牲にすることなく、大規模で計算量の多いLLMから小規模なLLMへ知識を移行する

- RouteLLM: LLM展開におけるコストと品質のトレードオフをナビゲートするオープンソースフレームワーク

- 検証者-検証者ゲームがLLM出力の可読性を向上させる

- 金魚のように、暗記をするな!ジェネレーティブLLMで暗記を軽減する

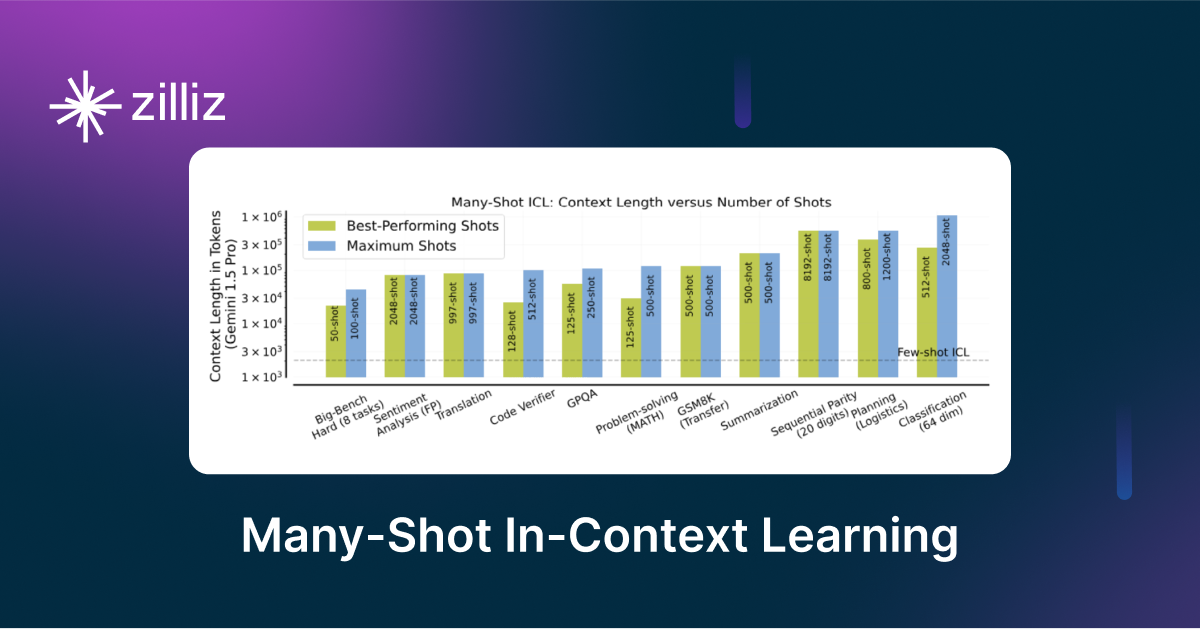

- LLMにおけるメニーショット・インコンテキスト学習のパワーを解き放つ

- 双眼鏡でLLMを発見:機械生成テキストのゼロショット検出

今日のAI主導の世界では、Speech-to-Text技術が重要な役割を果たしている。人間と機械の間のコミュニケーションを効果的にする。聴覚障害者を支援したり、専門分野や学問分野のプロセスを合理化したりと、多様な目的に役立っている。

この技術は、スマートフォンやスマートスピーカーなど様々な機器に組み込まれている。その有効性は、音声コマンドの正確な解釈を保証する正確な書き起こし能力に依存している。医療や金融などの業界では、テープ起こし作業を自動化することで、重要な文書作成プロセスの効率を高め、手作業の必要性を減らすことができるため、音声テキスト化技術から大きな恩恵を受けています。

先進的なAIモデルであるOpenAI Whisperは、音声テキスト変換を再定義します。インターネット上の様々なソースから収集された強固な学習データにより、驚くべき精度と効率を提供します。その革新的なアプローチは、高度なニューラルネットワークアーキテクチャを使用して、多様なアクセント、背景雑音、専門用語を効果的に処理し、信頼性の高い書き起こしを保証します。

さらに、Whisperのリアルタイム処理能力は、高い精度とスピードを必要とする環境に適しており、ユーザー体験を向上させ、生産性を高めます。

OpenAI Whisperを理解する

Whisperは自動音声認識(ASR)システムであり、680,000時間に及ぶ多言語・マルチタスクの教師ありデータに基づいて学習されている。特筆すべきは、Whisperは多言語の音声を書き起こし、英語に翻訳することもできる。エンコーダー・デコーダー変換器](https://zilliz.com/glossary/large-language-models-(llmspha))として実装されたエンドツーエンドのアプローチに従っており、効率的で正確な音声からテキストへの変換が可能である。

Whisperのアーキテクチャを簡単に見てみよう。

ウィスパーのアーキテクチャ構成要素

Whisperモデルは主にオーディオチャンクを処理し、テキストセグメントに変換するためのエンコーダーとデコーダーブロックで構成されている。オーディオファイルに対して実行されるステップごとの処理と、それがどのようにテキスト出力に変換されるかを見てみよう。

入力セグメンテーション

Whispersのコアアーキテクチャは、30秒のオーディオチャンクを順次処理するように設計されている。これらのチャンクは前処理を受け、log-Mel スペクトログラム に変換される。このスペクトログラムは音声の重要な音響的特徴を捉え、音声信号の豊かな表現を提供します。

OpenAI Whisper Architecture ︓[[ソース](https://openai.com/research/whisper)]_。

エンコーダーブロック

その後、エンコードされた log-Mel スペクトログラムはエンコーダーに渡される。このエンコーダはオーディオ情報を処理し、コンパクトな表現を生成します。

デコーダーブロック

その後、エンコードされた表現はデコーダーに送られる。デコーダーの主なタスクは、エンコードされた音声情報に基づいて、対応するテ キストキャプションを予測することです。このモデルは特別なトークンを使用して、言語の識別、フレーズレベルのタイムスタンプ、多言語書き起こし、音声からテキストへの翻訳などの追加タスクを実行します。

音声を正確に処理するウィスパーとは?

Whisperの強みはその堅牢性とゼロショット性能にあり、これは独自のアーキテクチャ設計と学習手法に起因しています。その学習方法論により、様々なベンチマークに優れ、様々な言語やオーディオ設定で優れたパフォーマンスを発揮します。

この頑健性は、Whisperが英語以外の音声データセットに触れることで、様々な言語に対応できるようになったためである。このモデルには、単一言語のアプリケーションに最適な英語のみのバージョンも含まれている。Whisperは元の言語での書き起こしと英語への翻訳を交互に行うことで、音声からテキストへの翻訳を効果的に学習し、その適応性とリアルタイム処理能力に貢献している。

OpenAI Whisperのアプリケーション

OpenAI Whisperは様々な業界で実用化されており、ユーザーの生産性とアクセシビリティを大幅に向上させます。

テープ起こしサービス:Whisperは、多様なアクセントや困難な音声環境に精通しており、インタビュー、ポッドキャスト、講義を正確なトランスクリプトに変換する自動化に変革をもたらしました。また、多言語対応により、異なる言語間でもその価値を高めています。

バーチャルアシスタント:Whisperは、最新のLLMベースのバーチャルアシスタントのテープ起こし作業を支援します。そのリアルタイム性能は、音声制御のスマートホームデバイスやチャットボットにおけるスケジュール管理や情報検索のようなタスクを推進するための効率的な音声処理を保証します。

障害者向けアクセシビリティ・アプリケーション:Whisperは、アクセシビリティ機能を強化し、障がい者のためのテクノロジーをより包括的なものにするために不可欠です。音声制御インターフェース、クローズドキャプション、ライブイベントのリアルタイム文字起こしを可能にすることで、Whisperは情報やサービスへの平等なアクセスを保証します。

カスタマーサポートWhisperは、顧客からの電話をリアルタイムで書き起こすことで、カスタマーサービスとコールセンターのオペレーションを改善します。これにより、Whisperがテープ起こしを行う間、エージェントは顧客ニーズへの対応に集中することができ、効率性、品質保証、コンプライアンス監視の向上につながります。

医師と患者のやり取りを書き起こす:医療分野では、患者とのやり取りを文書化し、管理負担を軽減し、正確な医療記録を確保することで、専門家を支援します。患者メモの作成を自動化し、AIベースのヘルスケア・アプリケーションをさらに強化します。

コンテンツ作成の自動化**:Whisperは、テープ起こしを通じてコンテンツ制作を迅速化することで、コンテンツ制作者にメリットをもたらします。音声を書き起こし翻訳することで、国際的なコミュニケーションを促進します。さらに、車載環境では、Whisper はハンズフリー制御を可能にし、安全性を高めます。さらに、音声データを分析することで、セキュリティや監視にも役立ちます。

OpenAI Whisperの実装

開発者やAI実務者にとって、OpenAI Whisperをプロジェクトに組み込むことで、音声テキスト化タスクの効率を大幅に向上させることができます。この革新的な機能は、機械が話し言葉を書き言葉に書き換えることを可能にし、人間のコミュニケーションとデジタルデータ処理のギャップを埋めます。

以下は、Whisperの音声テキスト化機能をアプリケーションに組み込むためのステップバイステップのチュートリアルです。

**ステップ1:必要なライブラリのインストール

HuggingFace Transformers パッケージは、Whisper モデルを使用するために必要なすべてのツールを提供します。

| ------------------------------------------------------------------------------------------------------ | pip install --upgrade git+https://github.com/huggingface/transformers.git accelerated datasets settings settings[audio] | |.

**ステップ2:ウィスパーモデルのロード

WhisperモデルはHuggingFaceから直接ロードできる。適切なモデルのパスとパラメータを与えるだけでよい。

| is_available() else torch.float32 # set model path model_id = "openai/whisper-large-v3" # whisper model into memory model = AutoModelForSpeechSeq2Seq.from_pretrained( model_id, torch_dtype=torch_dtype, low_cpu_memem_usage=True, use_safetensors=True ) model.to(device) | . |

**ステップ3: オーディオ・プリプロセッサをロードする。

音声プリプロセッサはWhisperによって提供される。このプロセッサは、音声を30秒ごとに切り取ったり、ログメル・スペクトログラムを生成したりする。また、テキスト出力を埋め込むために必要な、事前に訓練されたテキスト・トークナイザーも含まれている。

| プロセッサ = AutoProcessor.from_pretrained(model_id) |

ステップ4:HuggingFaceパイプラインを作成する。

HuggingFaceパイプラインによって、開発者はモデルを実行するために必要な様々なコンポーネントを積み重ねることができる。Whisperの場合、モデルオブジェクト、トークナイザー、特徴抽出器が含まれる。また、batch_sizeやモデルを実行するデバイスのようなモデルパラメータを定義することもできる。

| pipe = pipeline( "automatic-speech-recognition", model=model, tokenizer=processor.tokenizer, feature_extractor=processor.feature_extractor, max_new_tokens=128, chunk_length_s=30, batch_size=16, return_timestamps=True, torch_dtype=torch_dtype, device=device, ) |

ステップ5:推論を実行する。

パイプラインが設定されたら、オーディオファイルを渡すだけで、必要な処理をすべて行ってくれる。ファイルのパスは、パイプオブジェクトに渡すことができます、

| Transcription_results = pipe('パス/to/audio.mp3')]。 |

Transcription_resultsは、さらに処理するために保存することができる。

より詳細な実装は公式のHuggingFaceリポジトリにあります。

課題と今後の展開

Whisperの音声認識精度は注目に値するが、いくつかの課題があり、研究者は注意を払う必要がある。以下にそのいくつかを挙げる:

背景雑音や様々なアクセントはWhisperの性能に影響を与えるため、そのような変化に対応するための効果的な改良が必要である。

さらに、Whisperは30秒の音声チャンクをうまく処理できるが、より長い録音は難題であり、実用的なテープ起こしのためにはさらなる開発が必要である。

さらに、Whisperの多言語サポートでは、すべての言語にわたって高い精度を維持することは依然として困難である。そのため、言語固有のモデルを微調整し、言語間の格差に対処することが、多様な言語や方言にわたって信頼性の高い文字起こしを行うために不可欠です。

Whisperのもう一つの重要な課題は、機密性の高い音声データを処理しながら、ユーザーのプライバシーとデータセキュリティを維持することにある。

現在進行中の研究開発

現在進行中の研究は、Whisper の機能を強化し、課題に対処することを目的としている。ハイパーパラメータの微調整やアルゴリズムの最適化など、モデルの効率と精度の最適化に取り組んでいます。

また、高度なノイズフィルタリングアルゴリズムを開発し、多様なデータセットでトレーニングすることで、厳しい環境下での性能を向上させることにも注力しています。さらに研究者は、医学や法律などの分野で精度を向上させるために、多言語サポートを強化し、ドメイン固有の知識を組み込むことを目指している。

結論

OpenAI Whisperは、その比類なき精度、堅牢性、多言語機能により、音声テキスト化技術における重要な進歩を象徴している。その革新的なインパクトは多岐にわたります:

聴覚障害者のアクセシビリティ、

ビジネスオペレーションの合理化

異文化コミュニケーション

現在進行中の研究開発努力は、Whisperの機能をさらに洗練させ、既存の課題に対処し、AI搭載アプリケーションの継続的な革新への道を開くことを目的としている。今後、AIを活用した音声処理は急速に進歩していくことが明らかです。したがって、音声の書き起こしにとどまらず、言語のニュアンスの理解や感情の分析など、AIの他の応用への探求と革新を促すことが不可欠です。これらにより、聴覚データの真の可能性を引き出し、エンド・ツー・エンドの自動AIアプリケーションを開発することが可能になる。