マルチモーダルAIの強化:音声、テキスト、ベクトル検索の橋渡し

この記事では、音声、テキスト、ベクトル検索を橋渡しすることで、マルチモーダルAIがどのようにAIシステムを強化するかを探る。

曲名を知らずに検索したことがあるだろうか。もしかしたら、歌詞やメロディ、あるいはその曲が醸し出すムードだけを覚えていたかもしれない。あなたが口ずさんだものを認識し、その曲を探し、歌詞を表示する、そのすべてを1回の検索で行えるAIを想像してみてほしい。このようなインテリジェンスは、AIが異なるタイプのデータを別々に扱うのではなく、結びつけることで可能になる。

ほとんどのAIシステムは、一度に1種類のデータを扱う。音声アシスタントは音声をテキストに変換してから処理し、検索エンジンは音を理解せずにキーワードに頼り、推薦システムは深い関係性ではなくメタデータに基づいてコンテンツを提案する。しかし、現実のアプリケーションはそれ以上のものを必要とする。マルチモーダルAIは、システムが異なるタイプのデータを処理し、結びつけることを可能にし、より柔軟で効果的なものにする。

この記事では、音声、テキスト、ベクトル検索を橋渡しすることで、マルチモーダルAIがどのようにAIシステムを強化するかを探る。何がAIをマルチモーダルにするのかを定義し、実際のアプリケーションを検証し、これらのモダリティをつなぐ音声処理、テキスト埋め込み、ベクトル検索の役割を分解する。最後に、これらのシステムを構築する上での課題と、開発者が利用できるツールについて説明する。

マルチモーダルAIを理解する

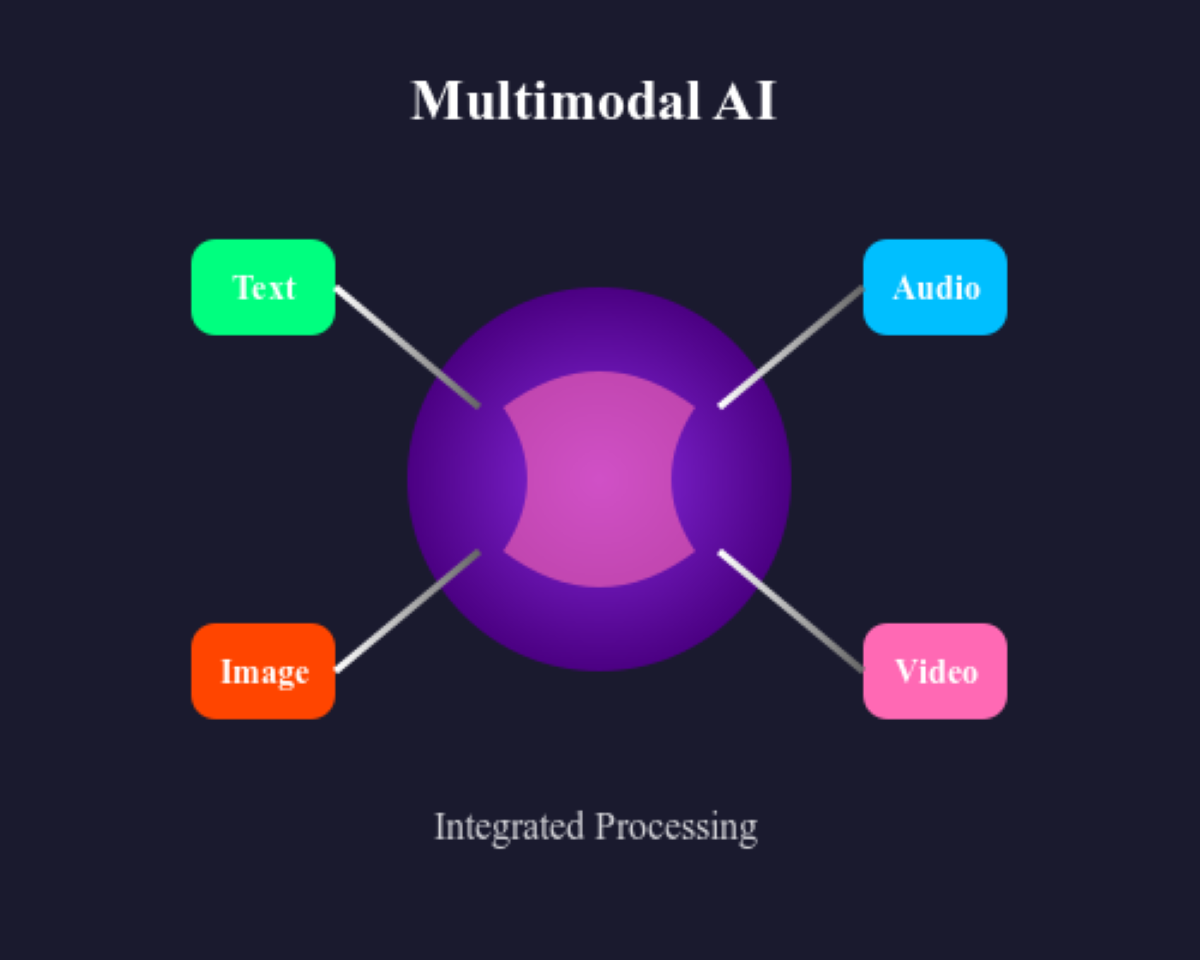

マルチモーダルAIとは、複数の種類のデータを処理・統合し、理解と意思決定を向上させる人工知能のことである。それぞれの形式を別々に扱うのではなく、それらをつなげることで、AIは書き言葉と一緒に話し言葉を分析したり、音声と説明を一致させたり、動画のキャプションを生成したりすることができる。この能力はAIをより適応性のあるものにし、人間が情報を処理する方法に近づける。

図:マルチモーダルAI:テキスト、音声、画像、動画を組み合わせて統合的に分析する。

マルチモーダルAIはすでに実世界のアプリケーションを形成しつつある。バーチャルアシスタントは音声認識と自然言語処理を併用し、音声コマンドをより正確に理解する。検索エンジンは、正確なファイル名に依存するのではなく、テキストの説明に基づいてオーディオ・クリップを検索する。AIが生成する字幕やポッドキャストの要約は、音声テキスト処理と言語モデルを組み合わせてアクセシビリティを向上させる。異なるフォーマットをリンクさせることで、マルチモーダルAIはより自然なインタラクションとより優れた検索機能を可能にする。

マルチモーダルAIにおける音声の役割

音声は最も表現力豊かなデータ形式の一つである。音声は、スピーチ、トーン、音楽、環境音など、言葉以上の意味を持つものをすべて捉えます。マルチモーダルAIにおいて、音声はテキストだけでは伝えきれない文脈、感情、意図のレイヤーを追加することで理解を深める。例えば、音声アシスタントは話された言葉を処理するだけでなく、緊急性や感情を検出するためにトーンも分析する。

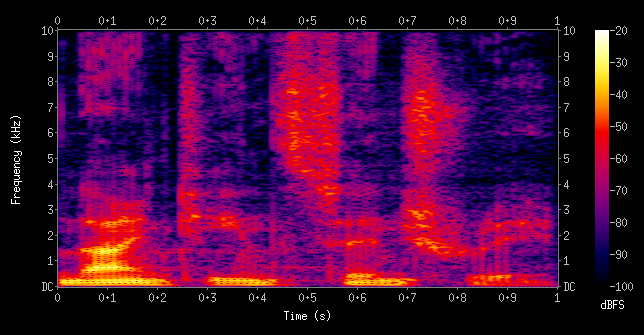

音声をマルチモーダルAIに役立てるには、AIが処理できる形式に変換する必要がある。スペクトログラムや埋め込みなどの特徴抽出技術は、生の音声を構造化データに変換するのに役立つ。スペクトログラムは周波数と振幅を経時的に可視化し、AIがパターンを認識できるようにする。これは、信号の周波数コンテンツが時間とともにどのように変化するかを示すスペクトログラムの例で、色は振幅を表しています。

図:スペクトログラムの例

出典:_ ウィキペディア

一方、エンベッディングは音声を、異なるモダリティ間で比較可能な密な数値表現に変換する。Wav2Vec](https://zilliz.com/learn/top-10-most-used-embedding-models-for-audio-data)やWhisperのようなディープラーニングモデルは音声認識を向上させ、AIが話し言葉を書き言葉や意味と結びつけることを可能にする。

ウィスパー](https://assets.zilliz.com/Figure_How_models_like_Wav2_Vec_or_Whisper_transform_audio_signals_into_dense_embeddings_35071b3349.png)

図:Wav2VecやWhisperのようなモデルが音声信号をどのように高密度の埋め込みに変換するか_。

音声とテキストを統合することで、新たな可能性が開ける。音声からテキストへの変換により、AIは音声コマンドを処理し、会議を書き起こし、アクセシビリティを向上させることができる。CLIP](https://zilliz.com/ai-faq/what-is-clip)やFlamingoのようなマルチモーダルモデルは、AIが音声を画像やテキストに関連付けることを可能にし、コンテンツの検索や取得をより直感的にする。音声と構造化データをリンクさせることで、AIは孤立した音声認識の枠を超え、よりリッチで柔軟なアプリケーションを構築することができる。

マルチモーダルAIにおけるテキストの役割

音声がトーン、感情、環境コンテキストを捉える一方で、テキストは構造と精度を提供する。音声をテキストに変換することで、AIは音声言語をより効率的に処理することができ、検索、比較、分析が容易になる。マルチモーダルAIでは、テキストは異なるタイプのデータ間の橋渡しの役割を果たし、話し言葉を書き言葉と結びつけ、音声を画像や動画などの他のフォーマットと結びつける。

テキストは情報検索において重要な役割を果たす。ユーザーは、何時間もの音声をブラウズするのではなく、フレーズを入力してポッドキャストを検索するかもしれない。BERT](https://zilliz.com/learn/what-is-bert)、GPT、T5のようなモデルを使用したテキスト埋め込みによるAIシステムは、正確な単語ではなく意味に基づいてコンテンツを検索するセマンティック検索を可能にする。音声と組み合わせることで、AIは関連する音声クリップを検索し、話し言葉の内容を書き起こし、要約を生成することができる。

マルチモーダルAIは、テキストと他のフォーマットとの相互作用も強化する。クロスモーダル検索により、AIはテキストの説明に基づいてオーディオクリップを検索したり、話し言葉のフレーズを文書にマッチさせたりすることができる。この機能は、音声検索、メディア・タグ付け、自動テープ起こしツールに役立つ。テキストと音声を統合することで、AIはより適応的になり、アクセシビリティ、検索精度、コンテンツ推薦が向上する。

ベクトル検索:モダリティ間の接着剤

音声やテキストは貴重な情報を提供してくれるが、それらを効率的に比較・検索する方法がなければ、その潜在的な可能性を十分に引き出すことはできない。ベクトル検索は、異なるタイプのデータをembeddingsに表現することでこの問題を解決する。[embeddings]は、AIが分析・比較できるデータの密な数値表現である。正確な単語やファイル名を検索する代わりに、AIは意味に基づいてコンテンツを検索することができ、ユーザーは自然なクエリを通じて関連するオーディオクリップ、トランスクリプト、または関連するコンテンツを見つけることができる。

**ベクトル検索の仕組み

文章、スピーチクリップ、音声パターンがAIモデルによって処理されると、高次元空間のベクトルに変換されます。この空間では、類似したコンテンツがより近くに表示されるため、単語や音声が完全に一致しなくても、AIが関連する結果を取得することができます。

例えば、「気候変動政策」に関するポッドキャストのエピソードを検索するユーザーは、録音で話された言葉を正確に入力する必要はない。システムが音声を埋め込み処理し、Milvusのようなベクトルデータベースに保存していれば、キーワードの一致だけでなく、意味的な類似性に基づいて関連するコンテンツを検索することができる。このアプローチにより、AIは従来のキーワードベースの検索を超え、より深い意味に基づいてコンテンツをマッチングさせることができる。

ベクトルを介したオーディオとテキストの橋渡し。

テキストとオーディオは異なる構造をしているが、ベクトル検索はそれらを結びつけることを可能にする。音声テキスト変換は、話し言葉をテキストに変換し、それをベクターデータベースに埋め込んで保存することができる。これにより、AIはテキストの説明に基づいてオーディオコンテンツを検索できるようになり、正確な表現に頼ることなく、サウンドクリップ、トランスクリプション、または話し言葉を簡単に検索できるようになります。

逆に、音声埋め込みは、AIが意味に基づいてサウンドクリップを認識し、検索することを可能にする。音声埋め込みで訓練されたシステムは、似たような音声パターンや音響特徴を持つ2つの異なる録音が関連していることを理解できる。これにより、鼻歌で音楽を検索したり、関連する効果音を検索したり、異なるエピソード間で類似したポッドキャストのディスカッションを検索したりすることが可能になる。

統一されたマルチモーダルAIパイプラインの構築

音声、テキスト、ベクトル検索を1つのAIシステムにまとめるには、構造化されたパイプラインが必要だ。シームレスなマルチモーダル検索を可能にするためには、各タイプのデータを効率的に処理、保存、検索する必要がある。よく設計されたパイプラインは、音声コマンド、テキストクエリ、音声ベースの検索のいずれであっても、AIが異なるフォーマットを解釈し、意味のある結果を提供できることを保証します。

モダリティを超えた処理、保存、検索

マルチモーダルAIパイプラインは、処理、保存、検索の3つの主要コンポーネントで構成される。各ステップは、異なるデータタイプが効率的に処理され、意味のある方法で検索できることを保証する。

1.**音声データとテキストデータは、マルチモーダルシステムでリンクする前に、まず準備する必要がある。音声の場合、前処理によってノイズを除去し、明瞭度を向上させ、音声やその他の音パターンを正確に分析できるようにする。音声に話し言葉が含まれている場合は、音声テキスト化モデルがそれを書き起こし、テキストベースの検索を可能にします。音楽や環境音など、音声以外の音声は、特徴抽出技術を用いて構造化された表現に変換されます。

テキストデータは独自の処理パイプラインを経て、クリーニングされ、トークン化され、意味的な意味を捉える埋め込みデータに変換される。この変換により、AIはテキストクエリを他のテキストエントリや音声由来の表現と比較することができる。音声とテキストは本質的に構造が異なるため、アライメント技術によって共通の空間にマッピングされ、音声データと文字データの間に意味のある関係を確立することができる。

2.**データを処理した後は、検索のために効率的に保存する必要がある。Milvusのようなベクトルデータベースは、埋め込みデータを保存するために使用され、迅速かつ正確な類似度ベースの検索を可能にします。単語の完全一致に依存する従来のデータベースとは異なり、ベクトルデータベースは意味に基づいてデータをインデックス化し、関連するコンテンツのクロスモーダル検索を可能にする。 エンベッディングに加え、メタデータの保存も重要な役割を果たす。各ベクトルと共に、タイムスタンプ、ソース参照、コンテンツカテゴリなどの追加メタデータが保存される。これは、AIが検索結果を絞り込むのに役立つ文脈情報を提供することで、検索精度を向上させる。

3.検索:* マルチモーダルAIシステムは、テキスト記述、音声コマンド、あるいは音声スニペットなど、さまざまなタイプのユーザークエリを処理しなければならない。クエリを受信すると、保存されているベクトルと比較される前に処理され、エンベッディングに変換される。これにより、システムは正確なキーワードではなく、意味に基づいて関連するマッチを見つけることができる。検索プロセスはベクトル類似性検索に依存しており、システムはベクトル空間における位置に基づいて入力クエリに最も近いマッチを検索する。

マルチモーダル検索の実世界での応用

うまく構造化されたマルチモーダルAIパイプラインは、情報検索をより直感的かつ効率的にすることで、いくつかの実世界での応用を可能にする。これらのアプリケーションの一部を紹介する:

1.**従来の検索エンジンは入力されたクエリに依存していたが、マルチモーダルAIはユーザーが音声コマンドを使用して検索できるようにする。これは、ハンズフリーのインタラクション、アクセシビリティ・ツール、スマート・アシスタントにとって特に有用である。ベクトル検索は、キーワードのみに基づいて結果を検索するのではなく、AIが話し言葉による質問を解釈し、関連するテキストや音声コンテンツと照合し、意味のある応答を提供することを可能にする。

2.音声コンテンツの書き起こしおよび分類:音声テキスト変換技術は、話し言葉を検索可能なテキストに変換し、AIシステムが大量の音声データを自動的に書き起こし、整理することを可能にする。これは、ユーザーが何時間ものコンテンツを手動で聞くことなく、特定のトピックを見つける必要があるインタビューや会議の録音にとって価値がある。分類はさらにアクセシビリティを向上させ、テーマ、センチメント、話者の特定に基づいてコンテンツをインデックス化することを可能にする。

3.コンテンツ推薦システム: マルチモーダルAIは、異なるフォーマットのユーザーの嗜好を分析することで、コンテンツ推薦を強化する。例えば、音楽ストリーミング・サービスは、テキスト・レビュー、歌詞、またはユーザーが作成した説明に基づいて曲を提案することができる。同様に、ポッドキャスト・プラットフォームは、ユーザーが読んだばかりの記事に文脈的に関連するエピソードを推薦することができる。音声とテキストをベクトル検索で結びつけることで、AIはより関連性の高い、パーソナライズされたレコメンデーションを提供することができる。

音声、テキスト、ベクトル検索を統一されたシステム内で構造化することで、マルチモーダルAIはよりスマートな検索、取得、推薦を可能にする。このアプローチは、AIが異なるデータ形式を理解し、接続する方法を改善し、人間とコンピュータのインタラクションをより自然で効率的なものにする。

マルチモーダルAIシステム構築のためのツールとフレームワーク

マルチモーダルAIシステムの構築には、異なるフォーマットのデータを処理、保存、検索するための適切なツールが必要だ。音声、テキスト、ベクトル検索を統合することの複雑さは、開発者がこれらのタスクを効果的に処理できる効率的なモデルとデータベースを必要としていることを意味する。いくつかのフレームワークやライブラリは、すぐに使えるソリューションを提供し、マルチモーダルAIアプリケーションの開発と展開に必要な時間と労力を削減します。

CLIP:マルチモーダル理解のための言語と画像の接続

CLIP (Contrastive Language-Image Pretraining)は、OpenAIによって開発されたAIモデルで、共有された埋め込み空間を通してテキストと画像を結び付けます。主に言語と画像を結びつけるために設計されているが、その対照学習アプローチは音声を含む他のモダリティに拡張することができる。完全な一致ではなく、意味に基づいて異なるタイプのデータを関連付けるようAIを訓練することで、CLIPはクロスモーダルな検索と取得の改善に役立つ。

例えば、CLIPを使えば、あらかじめ定義されたラベルに頼ることなく、「バイオリンを演奏している人」の写真を見つけるなど、テキストの説明に基づいて画像を検索することが可能になる。マルチモーダルAIパイプラインでは、同様の原理をオーディオクリップと説明文のリンクに適用することで、ユーザーが自然言語を使って音や音楽を検索できるようになる。

DeepAI:AIアプリケーションにおける音声とテキストの橋渡し

DeepAIは、AIアプリケーションに音声とテキスト処理を統合するのに役立つAPIとモデルを提供する。音声からテキストへの変換、テキストから音声への合成、自然言語理解のためのツールを提供します。これらの機能は、話し言葉と書き言葉の間のシームレスなインタラクションを必要とするアプリケーションに不可欠です。

例えば、音声検索エンジンやテープ起こしサービスでは、DeepAIのモデルは話し言葉のクエリをテキストに変換し、関連するコンテンツとマッチングさせることができます。これにより、ユーザーは音声コマンドを使用して映画のエピソード、ニュース記事、または音楽ファイルを取得することができ、マルチモーダルシステムにおけるアクセシビリティとユーザビリティが向上します。

ハギング・フェイス事前学習済みモデルとマルチモーダルパイプライン

Hugging Faceは、自然言語処理、音声認識、およびマルチモーダル学習のための膨大な事前学習済みモデルのコレクションを提供する、AI開発のための最も広く使用されているプラットフォームの1つです。開発者が大規模なトレーニングや計算リソースを必要とせずに、これらのモデルをアプリケーションに統合できる使いやすいAPIを提供している。

マルチモーダルAIのために、Hugging Faceは、テキストと音声を一緒に処理する変換器ベースのモデルを提供しています。開発者は、音声認識用のWhisper、テキスト埋め込み用のBERT、クロスモーダル検索用のCLIPのようなモデルにアクセスすることができます。特定のタスクでこれらのモデルを微調整する能力により、Hugging Faceは音声とテキストを結びつけるAIシステムを構築するための貴重なリソースとなります。

ベクトルデータベースと検索エンジン

ベクトル・データベースは、異なるデータタイプ間で効率的な類似性検索を可能にするため、マルチモーダルAIにとって不可欠である。Milvusは、大規模なAIアプリケーションのために設計されたオープンソースのベクトルデータベースであり、ベクトル埋め込みデータの高速なインデックス化と検索を提供する。テキスト、音声、画像を横断した検索をサポートしており、リアルタイムの検索機能を必要とするマルチモーダルアプリケーションに最適です。

Milvus上に構築されたZilliz Cloudは、ベクトル検索を大規模に展開するためのフルマネージドソリューションを提供する。インフラ管理と最適化を行うことで、マルチモーダルAIを本番システムに統合するプロセスを簡素化する。開発者はZilliz Cloudを使って埋め込みデータを効率的に保存・取得し、音声対応検索エンジンやマルチメディア・コンテンツ発見プラットフォームのようなアプリケーションのための高速で正確な検索結果を確保することができる。

マルチモーダルトランスフォーマー

トランスフォーマーは、モデルが長いデータシーケンスを効率的に処理できるようにすることで、AIに革命をもたらしました。トランスフォーマーベースのモデルの中には、マルチモーダルAI用に特別に設計されたものもあり、複数のデータタイプを同時に処理し理解することができます。

T5(Text-to-Text Transfer Transformer)やmBART(Multilingual Bidirectional and Auto-Regressive Transformer)のようなモデルは、トランスフォーマーの能力をテキスト以外にも拡張し、AIが書き言葉と話し言葉の両方を扱うことを可能にしている。これらのモデルは、自動テープ起こし、言語翻訳、音声ファイルのテキストベースのコンテンツ要約などのタスクに使用されます。

これらのフレームワークやツールを活用することで、音声、テキスト、ベクトル検索をシームレスにつなげたマルチモーダルAIシステムを構築することができます。事前に訓練されたモデル、ベクターデータベース、マルチモーダル変換器のいずれを通じてであれ、これらのテクノロジーは、異なるフォーマットの情報を理解し検索するインテリジェントなアプリケーションを作成するための基盤を提供します。

マルチモーダルAIの課題と限界

マルチモーダルAIは、システムが異なるデータ型にまたがる情報を理解し検索する方法を強化する一方で、いくつかの課題ももたらす。音声、テキスト、ベクトル検索を統合するには、効率的な処理、同期、多様なデータ構造の取り扱いが必要となる。AIシステムの規模が拡大するにつれ、公平性、正確性、リアルタイムのパフォーマンスを確保するために、技術的および倫理的な懸念にも対処しなければならない。

**データ同期

マルチモーダルAIシステムは、音声やテキストなど、異なるフォーマットやタイムシーケンスで存在することが多い、異なるタイプのデータを整列させる必要があります。例えば、Speech-to-Textアプリケーションでは、トランスクリプションは正確なタイミングで話し言葉と一致しなければならない。このアライメントがずれると、検索と取得の精度が低下します。これらのモダリティを同期させるには、時間に依存するデータを効率的に処理しリンクできるモデルが必要であり、多くの場合、微調整されたニューラルネットワークとタイムスタンプマッピング技術が必要となる。

**計算複雑性

複数のモダリティを同時に処理するには、かなりの計算能力が必要です。音声をエンベッディングに変換し、テキスト表現を生成し、ベクターデータベースを横断して類似性検索を実行するには、すべて高性能なインフラが必要です。マルチモーダルデータセットでディープラーニングモデルをトレーニングするには、大規模なGPUまたはTPUクラスタが必要で、開発と展開にコストがかかります。精度を維持しながら効率的にモデルを最適化することは、開発者にとって依然として重要な課題です。

**データのスパース性と不均衡

マルチモーダルデータセットでは、すべてのデータタイプが同じように利用できるわけではありません。アプリケーションによっては、テキストデータは豊富でも音声サンプルは限られており、モデル学習に影響を与える不均衡が生じます。例えば、音声検索システムは、特定の言語やアクセントが支配的なデータセットでトレーニングされた場合、特定のタイプの音声コンテンツを検索するのに苦労するかもしれません。このようなギャップに対処するためには、ロバスト性を向上させるためのデータ増強技術と多様なトレーニングデータセットが必要です。

倫理的懸念とバイアスについて

マルチモーダルAIシステムは、学習データからバイアスを受け継ぐ。音声モデルやテキストモデルの学習に使用されるデータセットに、言語、アクセント、人口統計に関連するバイアスが含まれている場合、システムは歪んだ結果を生成する可能性がある。例えば、音声認識モデルは、特定のアクセントでは優れた性能を発揮しますが、他のアクセントでは苦戦し、不公平なユーザー体験につながる可能性があります。AI駆動型アプリケーションの包括性と公平性を確保するには、慎重なデータセットのキュレーションとバイアス緩和戦略が必要です。

**レイテンシーとリアルタイム処理

音声アシスタントやリアルタイム検索エンジンなど、多くのマルチモーダルAIアプリケーションは、スムーズなユーザー体験を提供するために低レイテンシーを必要とします。しかし、異なるモダリティ間のデータの処理と検索には時間がかかります。音声からテキストへの変換、埋め込み生成、ベクトル類似検索は、リアルタイムの要求を満たすためにミリ秒単位で行わなければならない。クエリ処理の最適化、モデル推論時間の短縮、ハードウェア効率の向上は、応答性の高いマルチモーダルシステムを実現するために不可欠です。

このような課題にもかかわらず、ディープラーニング、ベクトル検索、スケーラブルなAIインフラストラクチャの進歩は、これらの制限の多くを克服するのに役立っている。マルチモーダルAIが進化し続ける中、計算効率、精度、公平性のバランスをとるソリューションが、これらのシステムをより効果的で利用しやすいものにする鍵となるだろう。

結論

マルチモーダルAIは、AIシステムが異なるタイプのデータを処理し、接続する方法を変革し、より自然なインタラクション、正確な検索、より優れたコンテンツ推薦を可能にしている。データの同期や計算需要などの課題は存在するが、ベクトル検索、ディープラーニング、スケーラブルなインフラストラクチャの進歩により、これらのシステムはより実用的になっている。適切なツールを使えば、開発者は音声、テキスト、検索をシームレスに統合するAIを構築し、アクセシビリティとユーザー体験を向上させることができる。AIが進化するにつれ、複数のモダリティを組み合わせることが、よりインテリジェントで適応性の高いアプリケーションを開発する鍵となるだろう。