ChromaとDeep Lake:ニーズに合ったベクターデータベースの選択

AIやデータ駆動型テクノロジーの進歩に伴い、アプリケーションに適切なベクターデータベースを選択することがますます重要になってきている。ChromaとDeep Lakeは、この分野における2つの選択肢です。ベクターデータベースとは?

ChromaとDeep Lakeを比較する前に、まずベクターデータベースのコンセプトについて説明します;

ベクトルデータベース](https://zilliz.com/learn/what-is-vector-database)は、特に高次元のベクトルを格納し、クエリするために設計されています。ベクトルは非構造化データの数値表現です。これらのベクトルは、テキストの意味、画像の視覚的特徴、または製品の属性などの複雑な情報をエンコードします。効率的な類似検索を可能にすることで、ベクトルデータベースはAIアプリケーションの役割を果たし、より高度なデータ分析と検索を可能にする。

ベクトルデータベースの一般的なユースケースには、電子商取引の商品推奨、コンテンツ発見プラットフォーム、サイバーセキュリティにおける異常検知、医療画像分析、自然言語処理(NLP)タスクなどがある。また、AI幻覚のような問題を軽減するために、外部知識を提供することによって大規模言語モデル(LLM)の性能を向上させる技術であるRAG(Retrieval Augmented Generation)でも役割を果たしている。

市場には、以下のような多くの種類のベクトル・データベースがある:

- Milvus](https://zilliz.com/what-is-milvus)、Zilliz Cloud(フルマネージドMilvus)など。

- Faiss](https://zilliz.com/learn/faiss)やAnnoyのようなベクトル検索ライブラリ。

- Chroma](https://zilliz.com/blog/milvus-vs-chroma)やMilvus Liteのような軽量ベクトルデータベース。

- 小規模なベクトル検索が可能なベクトル検索アドオンを備えた従来のデータベース**。

Chromaはベクトルデータベースであり、Deep Lakeはベクトル埋め込みに最適化されたデータレイクである。この記事では、両者のベクトル検索機能を比較する。

Chromaを理解する

ChromaはオープンソースのAIネイティブ・ベクター・データベースで、AIアプリケーションの構築プロセスを簡素化する。Chromaは、大規模言語モデル(LLM)と、それらが効果的に機能するために必要なデータとの橋渡しをする。Chromaの主な目的は、知識、事実、スキルにLLMが簡単にアクセスできるようにすることで、AIを搭載したアプリケーションの開発を効率化することだ。Chromaの中核は、ベクターデータを管理するためのツールを提供することで、開発者はエンベッディング(データのベクター表現)を関連するメタデータとともに保存することができる。この機能は、多くのAIアプリケーションにとって非常に重要であり、ベクトル関係に基づく効率的な類似検索やデータ検索を可能にします。

Chromaの主な強みのひとつは、シンプルさと開発者の生産性を重視していることだ。Chromaの開発チームは、開発者がベクトル検索機能をアプリケーションに素早く統合できるよう、直感的なインターフェイスを作ることを優先した。使いやすさを重視するあまり、パフォーマンスが犠牲になることはありません。Chromaは高速かつ効率的に設計されているため、さまざまなアプリケーションに適している。Chromaはサーバーとして動作し、PythonとJavaScript/TypeScriptの両方に対応したファーストパーティーのクライアントSDKを提供しているため、開発者は好みのプログラミング環境で柔軟に作業することができます。

Chromaの機能は、関連するエンベッディングのグループであるコレクションの概念を中心に展開されます。Chromaのコレクションにドキュメントを追加すると、システムは自動的にトークン化し、指定されたエンベッディング関数(指定されていない場合はデフォルトの関数)を使ってエンベッディングを行います。この処理により、生データは効率的に検索できるベクトル表現に変換される。エンベッディングとともに、Chromaでは各文書のメタデータを保存することができ、これにはデータのフィルタリングや整理に役立つ追加情報を含めることができます。Chromaは柔軟なクエリーオプションを提供しており、ベクトル埋め込みまたはテキストクエリーのいずれかを使用して類似文書を検索し、ベクトルの類似性に基づいて最も近い一致を返します。

Chromaはいくつかの点で際立っている。そのAPIは直感的で使いやすいように設計されており、ベクターデータベースを初めて使う開発者にとっても学習曲線が少なくなっている。様々なタイプのデータをサポートし、異なるエンベッディングモデルを使用することができるため、ユーザーは特定のユースケースに最適なアプローチを選択することができる。Chromaは、他のAIツールやフレームワークとシームレスに統合できるように構築されており、複雑なAIパイプラインに適している。さらに、Chromaはオープンソース(ライセンスはApache 2.0)であるため、透明性が高く、コミュニティ主導の改善やカスタマイズが可能です。Chromaチームは、マネージドサービス(Hosted Chroma)の計画や様々なツールの改善など、積極的に機能強化に取り組んでおり、継続的な開発とサポートへのコミットメントを示している。

ディープレイクを理解する

Deep Lake](https://github.com/activeloopai/deeplake)は、画像、音声、動画、その他の非構造化データなどのベクターデータやマルチメディアデータの保存、管理、クエリを処理するために設計された特殊なデータベースシステムであり、AIや機械学習アプリケーションでますます使用されるようになっている。Deep Lakeは、データレイクおよびベクトルストアとして使用することができます;

データレイクとしてのDeep Lake: Deep Lakeは、画像、音声、動画、テキスト、NIfTIのような医療画像フォーマット、メタデータなどの非構造化データを、ディープラーニングのパフォーマンスを高めるために設計されたバージョン管理されたフォーマットで、効率的に保存・整理することができます。これにより、ユーザーはデータセットを迅速にクエリして視覚化することができ、高品質のトレーニングセットの作成が容易になります。 ;

ベクターストアとしてのDeep Lake: Deep Lakeは、テキスト、JSON、画像、音声、動画ファイルを含むvector embeddingsとその関連メタデータを保存・検索するための堅牢なソリューションを提供します。ローカル、お好みのクラウド環境、またはDeep Lakeのマネージドストレージにデータを保存できます。また、Deep LakeはLangChainやLlamaIndexのようなツールとのシームレスな統合も提供しており、開発者は検索拡張世代(RAG)アプリケーションを簡単に構築することができます。

主な違い

検索方法

Chroma:Chromaはベクトル類似性検索を使い、埋め込みに基づいた最適なマッチを返します。大規模言語モデル(LLM)を使ったRAGの構築に重点を置き、テキストベースのアプリケーションに最適化されています。Chromaは、ベクトルベースやテキストベースのクエリを含む柔軟なクエリオプションをサポートしているため、NLPのユースケースに非常に適しています。

Deep Lake: Deep Lakeもベクトル検索が得意だが、マルチメディアの埋め込みを扱うのが得意だ。画像、動画、音声ファイルに紐づくベクトルを横断的に検索できるため、多様なデータタイプを持つアプリケーションに最適だ。DeepLakeはLangChainやLlamaIndexと統合されており、特にRAG(retrieval-augmented generation)用の複雑な検索ワークフローに対応している。

データハンドリング

Chroma:Chromaは、構造化または半構造化データの埋め込みと関連するメタデータを管理するのに適しています。エンベッディングをコレクションにグループ化し、特定のユースケースのために関連データをグループ化することができます。メタデータもサポートしています。

Deep Lake: Deep Lakeは非構造化データ、画像、ビデオ、NIfTIのような医療フォーマットに適している。データレイクであり、ベクターストアでもあるので、膨大で多様なデータセットを保存し、バージョン管理し、クエリすることができる。マルチメディア・データを必要とするディープラーニング・パイプラインに最適です。

スケーラビリティとパフォーマンス

Chroma:Chromaは、スピードよりもシンプルさとパフォーマンスを優先するアプリケーションのために、軽量で高速です。スケーラビリティはまだ進化中であり、ホスト型Chromaは開発中です。

Deep Lake: Deep Lake は分散ストレージを含む大規模データセット向け。ローカル、クラウド、マネージドストレージをサポートし、エンタープライズユースでもシームレスに拡張できます。

柔軟性とカスタマイズ

Chroma:Chromaは関数の組み込みに柔軟性があり、独自のモデルをプラグインすることも、デフォルトを使用することもできます。シンプルなAPIとPythonやJavaScript用のSDKが用意されており、開発者向けにフォーカスされています。

Deep Lake: Deep Lakeはデータモデリングにおいてより柔軟性があり、より多くのフォーマットと埋め込みタイプをサポートしています。特にマルチメディアデータに対して高度なカスタマイズが可能なので、特殊なAIプロジェクトに向いている。

統合とエコシステム

Chroma:ChromaはLLMベースのワークフローや他のAIフレームワークと統合できる。Chromaはシンプルさと開発者に優しいツールに重点を置いているため、既存のパイプラインに簡単にプラグインできます。

Deep Lake: Deep LakeはLangChain、LlamaIndex、その他の一般的なAIツールと統合している。そのエコシステムはより広範で、AIとMLのワークフローをエンド・ツー・エンドで行うためのデータレイクとベクターストアの組み合わせに重点を置いている。

使いやすさ

Chroma:ChromaのシンプルなAPIとよく文書化されたSDKは、簡単に使い始めることができる。迅速なセットアップとシンプルさを求める開発者に適している。

ディープレイク:* ディープレイクは機能が豊富なため、特にデータレイクの概念に詳しくないユーザーにとっては、その機能を探求するのに時間がかかるかもしれない。しかし、ドキュメントや可視化ツールのサポートにより、オンボーディングは管理しやすくなっている。

コスト

Chroma:オープンソースツールであるため、Chromaは無料で使用できる。

DeepLake:DeepLakeには、ローカルおよびクラウドストレージ用の無料階層があるが、マネージドストレージや大容量データの処理には、セットアップに応じて費用が発生する。

セキュリティ

Chroma:Chromaには基本的なセキュリティ機能があり、現在はシンプルさに重点を置いている。マネージド・サービスは将来的にもっと多くの機能を持つかもしれない。

Deep Lake: Deep Lake は暗号化、アクセス制御、認証メカニズムを備えており、高度なセキュリ ティを必要とするアプリケーションに適している。

Chromaを選ぶとき

Chromaは、LLMベースのアプリケーションを開発する開発者にとって良い選択です。検索支援生成(RAG)、自然言語処理、テキスト類似検索などのユースケースであれば、ChromaのシンプルなAPIと開発者ファーストの設計が適している。PythonとJavaScript/TypeScript用のシンプルでファーストパーティなSDKは、迅速な立ち上げと実行を可能にします。拡張性やマルチメディアのサポートよりも、使いやすさやセットアップの速さを重視するのであれば、Chromaはエンベッディングやメタデータの管理に重点を置いたソリューションです。

ディープレイクを選ぶとき

複数のデータ、画像、動画、音声をテキスト埋め込みとともに扱うアプリケーションには、Deep Lakeが適しています。非構造化データやマルチメディアファイルを管理するための堅牢なソリューションが必要なプロジェクトには、Deep Lakeのデータレイクとベクターストアがおすすめです。特に、バージョン管理や大規模データセットのクエリが重要なディープラーニングパイプラインに最適です。LangChainとLlamaIndexの統合により、Deep Lakeはテキストワークフローを超えた複雑なAIシステムを構築できる。

概要

ChromaとDeep Lakeはどちらもベクトル検索とAI開発に適している。Chromaはシンプルさ、開発者の生産性、テキストに特化したユースケースに適しており、Deep Lakeはマルチメディアや大規模な非構造化データに適している。どちらを選ぶかはあなた次第だ:テキストを多用するLLMワークフローにはChromaを、柔軟性とデータレイクが鍵となるマルチメディアや大規模AIパイプラインにはDeep Lakeを。

この記事ではChromaとDeep Lakeの概要を説明するが、特定のユースケースに基づいてこれらのデータベースを評価することが重要だ。このプロセスを支援するツールの1つが、ベクターデータベースのパフォーマンスを比較するために設計されたオープンソースのベンチマークツールであるVectorDBBenchだ。最終的には、特定のデータセットとクエリパターンを使って徹底的なベンチマークを行うことが、分散データベースシステムにおけるベクトル検索に対する、強力でありながら異なるこの2つのアプローチの間で、十分な情報に基づいた決断を下すために不可欠となる。

オープンソースのVectorDBBenchを使って、ベクターデータベースを自分で評価・比較する

VectorDBBenchは、高性能なデータ保存・検索システム、特にベクトルデータベースを必要とするユーザーのために設計されたオープンソースのベンチマークツールです。このツールにより、ユーザは独自のデータセットを用いてMilvusやZilliz Cloud(マネージドMilvus)などの異なるベクトルデータベースシステムの性能をテスト・比較し、ユースケースに最も適したものを決定することができます。VectorDBBenchを使用することで、ユーザーはマーケティング上の主張や逸話的証拠に頼るのではなく、実際のベクトルデータベースのパフォーマンスに基づいて情報に基づいた決定を下すことができます。

VectorDBBenchはPythonで書かれており、MITオープンソースライセンスの下でライセンスされています。VectorDBBenchは、その機能と性能の改善に取り組む開発者のコミュニティによって活発にメンテナンスされています。

VectorDBBenchをGitHubリポジトリ**からダウンロードして、我々のベンチマーク結果を再現したり、あなた自身のデータセットでパフォーマンス結果を得てください。

VectorDBBench Leaderboard](https://zilliz.com/vector-database-benchmark-tool?database=ZillizCloud%2CMilvus%2CElasticCloud%2CPgVector%2CPinecone%2CQdrantCloud%2CWeaviateCloud&dataset=medium&filter=none%2Clow%2Chigh&tab=1)で、主流のベクトルデータベースのパフォーマンスを簡単に見てみましょう。

ベクターデータベースの評価については、以下のブログをお読みください。

- ベンチマーク・ベクター・データベースのパフォーマンス:テクニックと洞察](https://zilliz.com/learn/benchmark-vector-database-performance-techniques-and-insights)

- VectorDBBench: Open-Source Vector Database Benchmark Tool](https://zilliz.com/learn/open-source-vector-database-benchmarking-your-way)

- ベクターデータベースを他のデータベースと比較する](https://zilliz.com/comparison)

VectorDB、GenAI、MLに関するその他のリソース

- ジェネレーティブAIリソースハブ|Zilliz](https://zilliz.com/learn/generative-ai)

- あなたのGenAIアプリのためのトップパフォーマンスAIモデル|Zilliz](https://zilliz.com/ai-models)

- RAGとは](https://zilliz.com/learn/Retrieval-Augmented-Generation)

- 大規模言語モデル(LLM)を学ぶ](https://zilliz.com/learn/ChatGPT-Vector-Database-Prompt-as-code)

- ベクトルデータベース101](https://zilliz.com/learn/what-is-vector-database)

- 自然言語処理(NLP)](https://zilliz.com/learn/introduction-to-natural-language-processing-tokens-ngrams-bag-of-words-models)

読み続けて

Build for the Boom: Why AI Agent Startups Should Build Scalable Infrastructure Early

Explore strategies for developing AI agents that can handle rapid growth. Don't let inadequate systems undermine your success during critical breakthrough moments.

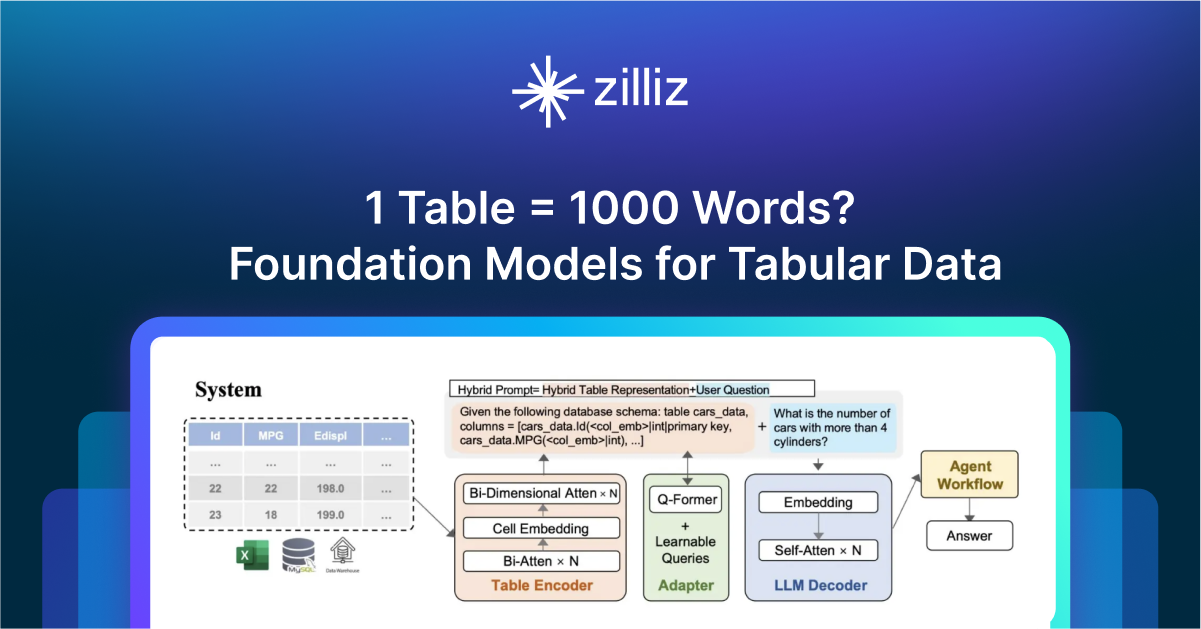

1 Table = 1000 Words? Foundation Models for Tabular Data

TableGPT2 automates tabular data insights, overcoming schema variability, while Milvus accelerates vector search for efficient, scalable decision-making.

Insights into LLM Security from the World’s Largest Red Team

We will discuss how the Gandalf project revealed LLMs' vulnerabilities to adversarial attacks. Additionally, we will address the role of vector databases in AI security.

The Definitive Guide to Choosing a Vector Database

Overwhelmed by all the options? Learn key features to look for & how to evaluate with your own data. Choose with confidence.