LangChainの紹介

LangChainの定義、ワークフロー、メリット、ユースケース、利用可能なリソースなど、LangChainを始めるためのガイド。

LangChain入門

LangChainは、LLM駆動型アプリケーション開発の最前線に立ち、開発者がテキストベースのシステムとインタラクションする方法を大幅に強化する多用途フレームワークを提供します。LLMと外部データソースをシームレスに統合することで、LangChainはアプリケーションのコンテキストを認識し、より効果的な推論を可能にし、ユーザ入力に対して首尾一貫しているだけでなく、関連情報に基づいた応答を提供します。この機能は、抽象的な言語モデルと、情報に基づいた意思決定に必要な特定の文脈的手がかりとのギャップを埋め、インテリジェントで応答性の高いアプリケーションを作成するための新たな可能性を解き放ちます。

LangChainのアーキテクチャの中核にはいくつかの主要コンポーネントがあり、それぞれが開発・配備プロセスを合理化するために細心の注意を払って作られているため、開発者は強力なアプリケーションを簡単に構築することができます。これらのコンポーネントは協調して動作し、LLMを扱うための包括的なツールキットを提供します:

1.LangChainライブラリ: PythonとJavaScriptの両方で利用可能なこれらのライブラリはLangChainフレームワークのバックボーンを形成します。これらのライブラリは幅広いインタフェースと統合を提供し、開発者が複雑なチェーンやエージェントを簡単に組み立てることを可能にします。これらのライブラリには、自然言語理解、テキスト生成、データ検索のような様々なタスクに対応する実装があらかじめ含まれており、開発者は基本的な複雑さを気にすることなく、アプリケーションロジックの構築に集中することができます。

2.LangChainテンプレート:開発プロセスをさらに簡素化するために、LangChainはLangChainテンプレートとして知られる展開可能な参照アーキテクチャのリポジトリを提供します。これらのテンプレートは、カスタマーサポートボットから自動コンテンツ生成ツールまで、様々なユースケースに対応する合理的なソリューションを提供します。これらのテンプレートを活用することで、開発者は、コンセプトからデプロイまでに必要な時間と労力を削減し、強固な基盤で自信を持ってプロジェクトを開始することができます。加えて、LangChainはプロンプトテンプレートを提供し、言語モデルが最適に扱えるフォーマットにユーザ入力をフォーマットする手助けをします。プロンプトテンプレートには、いくつかの例文、プロンプトの組み合わせ、部分的なプロンプトテンプレートがあります。

3.LangServe: LangChainベースのアプリケーションのデプロイは、LangServeで簡単になります。LangServeは、RESTful APIとしてLangChainチェーンのデプロイを容易にするために設計された専用ライブラリです。LangServeは、これらのチェーンが既存のシステムに容易に統合できることを保証し、多様なアプリケーション環境に互換性とスケーラビリティを提供します。これにより、大規模なインフラ修正を必要とすることなく、洗練されたLLM搭載アプリケーションを本番環境で展開することが可能になります。

4.LangSmith:LangSmithは、言語ベースのアプリケーション開発のライフサイクル全体を強化するホスト型開発者プラットフォームです。デバッグ、テスト、評価、監視のための堅牢なツールを提供し、開発者はアプリケーションを正確に微調整できます。LangSmithとLLMフレームワークとのシームレスな統合は、LangChainの機能を拡張し、言語中心のアプリケーションの最適化と保守を容易にします。これらのタスクを一元管理するプラットフォームを提供することで、LangSmithはイノベーションと効率性を促進し、開発者がLLMで可能なことの限界を押し広げることを可能にします。

これらのコンポーネントを組み合わせることで、LangChainはLLMの可能性を最大限に活用しようとする開発者にとって強力なフレームワークとなります。シンプルなチャットボットから複雑なAI駆動アプリケーションまで、LangChainはインテリジェントなだけでなく、効果的な実行に必要なコンテキストデータと深く統合されたアプリケーションを作成するために必要なツールとインフラを提供します。

##LangChainを始めよう

Python版LangChainの基本インストールパッケージを使ってLangChainを学び始めるのは、早くて簡単です。ベースインストールは基本的なもので、あなたが興味を持つかもしれない特定の統合のための依存関係は含まれていません。LangChainで使われるデフォルトのLLMはOpenAIで、OpenAIのAPIキーが必要です。

ピップ パイソン pip install langchain

もし、彼らのパーティーの統合を含むパッケージに興味がある場合は、以下のコミュニティ版を使用してください:

python

pip install langchain-community

LangChainウェブサイト](https://smith.langchain.com/)から無料のLangSmithアカウントを作成することもできます。

LangChainの特徴

LangChainは開発者が洗練された言語アプリケーションを構築できるように設計された機能を提供します。ここではLangChainのコア機能について詳しく説明します:

Context-Aware Responses:LangChainは、LLMを様々なコンテキスト・ソース(多くの場合ベクタDBに格納)に接続することで、アプリケーションがコンテキストを意識したレスポンスを生成することを可能にします。この機能により、アプリケーションはユーザのクエリを理解し、より有意義かつ合理的に応答することができます。

効率的な推論**:LangChainにより、アプリケーションは言語モデルを活用し、提供されたコンテキストに基づいて情報に基づいた決定を下すことができます。この機能により、アプリケーションは効果的な推論を行うことができ、ユーザのクエリに対してより正確で洞察に満ちたレスポンスを提供することができます。

統合の柔軟性**:LangChainは柔軟な統合オプションを提供し、開発者は言語モデルをアプリケーションにシームレスに統合することができます。プロンプトの指示、数ショットの例、またはコンテキストの他のソースであろうと、LangChainは異なるユースケースに適した様々な統合方法を提供します。

カスタマイズ可能なコンポーネント:LangChainはカスタマイズ可能なコンポーネントを提供しています。あらかじめ組み込まれた実装からカスタマイズ可能なテンプレートまで、LangChainは開発者に強力な言語パワーアプリケーションを構築するツールを提供します。

LangChainはどんな問題を解決しますか?

LangChainは、高度な言語理解と推論能力を必要とする人工知能向けアプリケーション開発の問題を解決します。チャットボット、バーチャルアシスタント、コンテンツ要約システムなど、多くの自然言語処理(NLP)タスクにおいて、人間の言語の文脈やニュアンスを理解することは、正確で適切な応答を提供し、合理的ではあるが誤った回答(AIの幻覚)をユーザーに提示することを避けるために極めて重要です。しかし、このようなアプリケーションをゼロから構築するのは、特に大規模言語モデル(LLM) を統合したり、文脈情報を管理したりするときに、複雑で時間がかかることがある。

LangChainは、言語モデルを利用したアプリケーションの開発を容易にする汎用的なフレームワークを提供することで、この課題に取り組んでいます。開発者は、言語モデルを、プロンプトの指示、数発の例文、その他のコンテンツなど、様々なコンテキストソースに接続することができ、コンテキストを意識したアプリケーションを作成することができます。LangChain表現言語とベクトルデータベースを活用することで、開発者は自然言語入力をより効果的に理解し応答できるアプリケーションを構築することができ、それによってユーザーインタラクションと全体的なユーザーエクスペリエンスを向上させることができます。

ユースケース別LangChainの使い方

LangChainがサポートするユースケースはたくさんあります。このセクションでは、最も人気のある3つのユースケースをレビューします:Retrieval Augmented Generation (RAG), RAG Chatbot, Summarization。

検索拡張世代 (RAG)

LangChainがベクターデータベースや大規模な言語モデルで使用するのに役立つテクニックのひとつに、Retrieval Augmented Generation (RAG)があります。RAGにより、開発者はユーザのクエリを深く正確に理解し応答するアプリケーションを構築することができます。RAGは、ベクターDBに保存され検索された情報を、大規模な言語モデルとブレンドして応答を生成する。外部の知識を活用することで、このアプローチは膨大な知識ソースから関連する情報を使用し、より正確で首尾一貫した、文脈に関連した出力を生成する。

LangChainとZilliz CloudによるRAG使用例](https://assets.zilliz.com/Retrieval_Augmented_Generation_RAG_use_case_20240220_083822_ef868474b5.png)

1.RAGソリューションに使用したいドキュメントのコレクションをまとめることから始めます。LangChainは、あらゆるタイプのドキュメント(html、pdf、コード)、あらゆるタイプのロケーション(S3、パブリックウェブサイト)、AirByteやUnstructuredとの統合のための100以上の異なるドキュメントローダーを持っています。

2.次に、テキストを意味的に意味のある小さな塊(多くの場合、文章)に分割する。テキスト分割ツールをカスタマイズできる軸は2つあります:テキストをどのように分割するか」「チャンクのサイズをどのように測定するか」です。また、LangChainを使用する場合、テキスト分割の種類が異なります。これらはName、Splits On (テキストをどのように分割するか)、Adds Metadata (メタデータを追加するかどうか)、Description (使用例に関する推奨事項)によって特徴付けられます。

3.分割の埋め込みを生成し、Zilliz CloudやオープンソースのMilvusのようなベクトルデータベースに保存します。LangChainのデフォルトはOpenAIで、OpenAIのキーとコストが必要です。プロトタイプの段階では、代わりにオープンソースモデルを検討することをお勧めします。

4.クエリ時に、クエリはベクトル埋め込みに変換され(注:最初に保存したテキストチャンクに使用したのと同じモデルを使用)、ベクトルデータベース内の意味検索のトリガーとして使用されます。その応答はLLMに送られ、信頼できる回答を生成する。

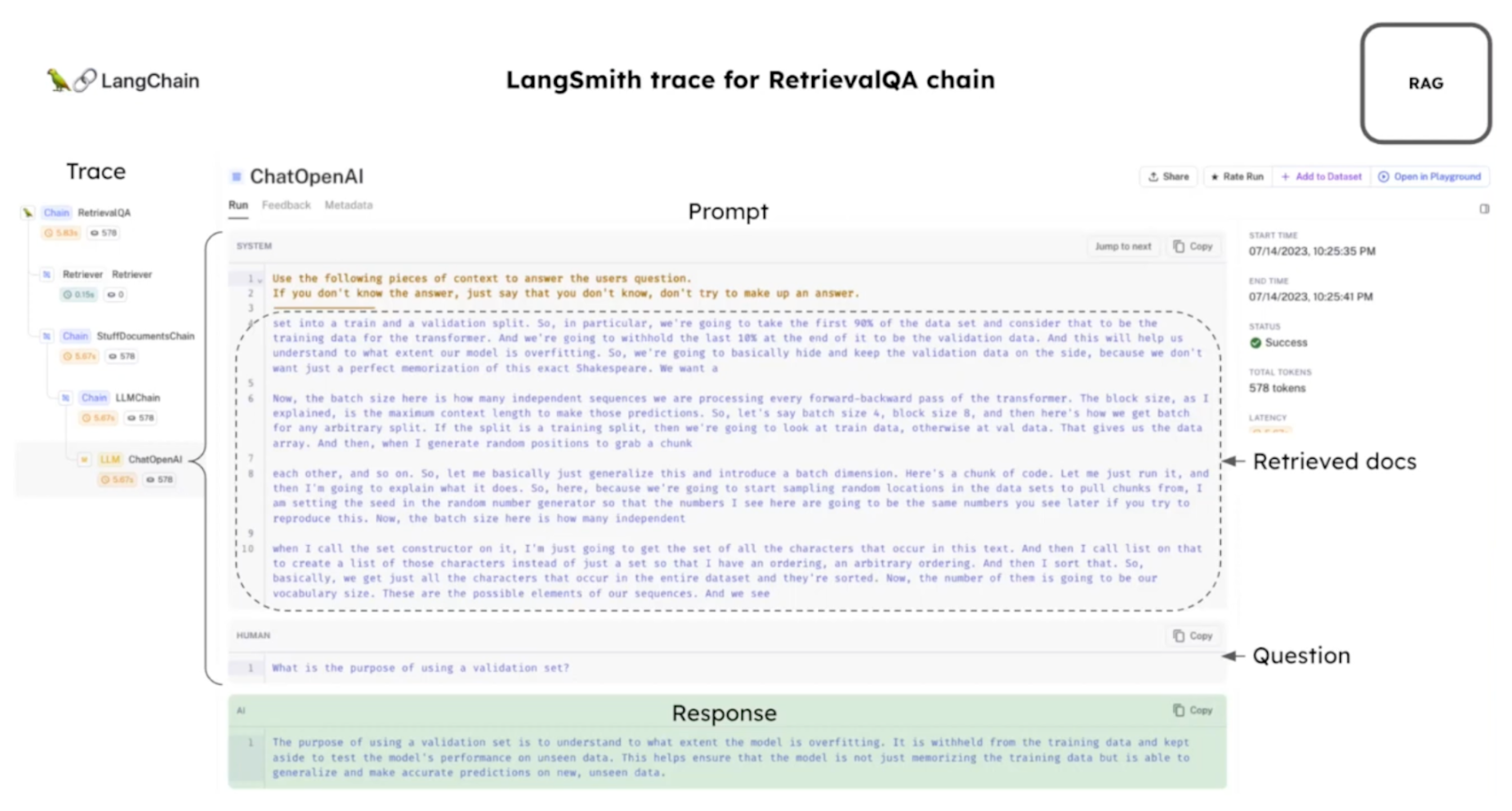

Zillizを使ったRAGユースケースのLangSmithトレース.png

Zillizを使ったRAGユースケースのLangSmithトレース.png

チャットボット

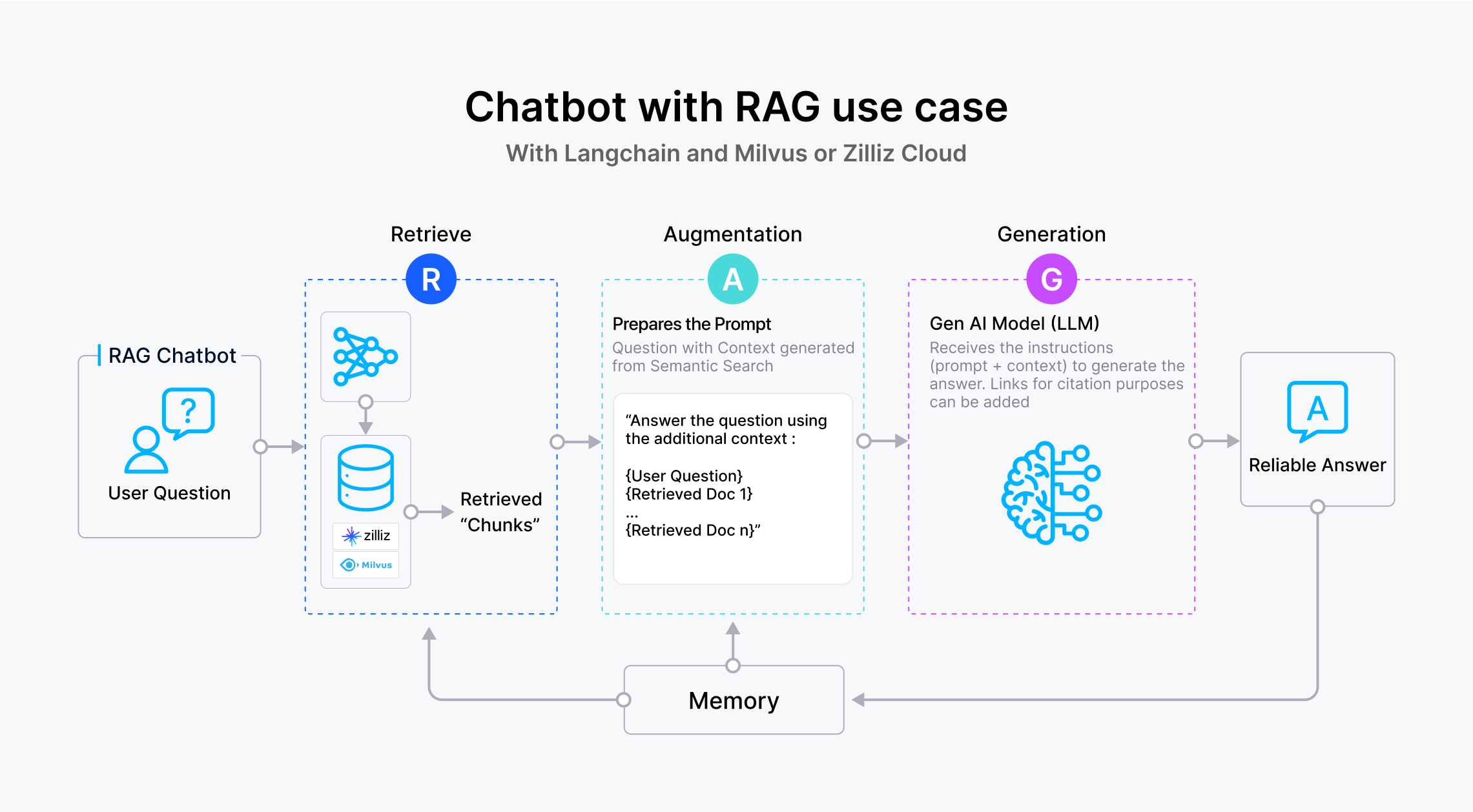

LangChainとZilliz Cloudを使ったRAGユースケースのチャットボット

LangChainとZilliz Cloudを使ったRAGユースケースのチャットボット

このChatbotは、先に説明したRAGのテクニックを活用し、その機能を強化するために "記憶 "の概念を統合しています。従来のRAGのユースケースとは異なり、RAGを使ったチャットボットは記憶機能を組み込んでおり、過去の会話を呼び出して現在の対話に組み込むことができる。例えば、ユーザーが以前議論したトピックについて問い合わせた場合、チャットボットはその会話の要約を取得し、進行中の対話に組み込むことができます。過去のチャットシーケンスをベクターデータベースに保存することで、チャットボットは、たとえ数日前や数週間前の会話であっても、現在の対話を豊かにするために過去の情報を効率的に取得し、活用することができます。

RAGチャットボット使用例のLangSmithトレース|Zilliz](https://assets.zilliz.com/Lang_Smith_trace_for_RAG_Chatbot_use_case_Zilliz_8a3010104a.png)

要約

LangChainとZilliz Cloudを使った要約ユースケース](https://assets.zilliz.com/Summarization_use_case_3_ways_20240220_083829_bb6e588834.png)

1.Summarizationユースケースでは、良いユーザーエクスペリエンスを保証するために、実装に加えるべき3つのことがあります。

コンテンツがLLMのコンテキストウィンドウに収まるほど小さい場合、要約を生成するプロンプトとともに、コンテンツ全体をLLMに送ることができます。

コンテンツが大きすぎてコンテキストウィンドウに収まらない場合は、テキストを分割して埋め込みデータを生成し、ベクトルデータベースに格納することができます。その後、意味的類似性検索を行い、その結果をプロンプトとLLMを使って要約を生成することができる(前述のRAGアプローチに似ている)。

最後に、LangChainで利用可能なMap Reduceアプローチを使うこともでき、プロンプトとLLMにコンテンツの抽出版を送ることができる。

LangChainとZillizクラウドとMilvusリソース

- 5分以内にLangChainとMilvusを使ってオープンソースチャットボットを構築する](https://zilliz.com/blog/building-open-source-chatbot-using-milvus-and-langchain-in-5-minutes)

- LangChainがセルフクエリを実装する方法](https://zilliz.com/blog/How-LangChain-Implements-Self-Querying)

- LangChainによるNotion Docsの検索拡張生成](https://zilliz.com/blog/retrieval-augmented-generation-on-notion-docs-via-langchain)

- LangChainによる様々なチャンキング戦略の実験](https://zilliz.com/blog/experimenting-with-different-chunking-strategies-via-langchain)

- LangChainを使ったベクトルデータベースのセルフクエリ](https://zilliz.com/blog/using-langchain-to-self-query-vector-database)

- LangChainでのプロンプティング](https://zilliz.com/blog/prompting-langchain)

- ChatGPTのインテリジェンスと効率の向上]()LangChainとMilvusの威力](https://zilliz.com/blog/enhancing-chatgpt-intelligence-efficiency-langchain-milvus)

- LlamaIndex、LangChain、Milvusを使った複数ドキュメントのクエリ](https://zilliz.com/learn/combine-and-query-multiple-documents-with-llm)

- LangChainでのプロンプティング](https://zilliz.com/blog/prompting-langchain)

- GPTCache、LangChain、強力なアライアンス](https://zilliz.com/blog/gptcache-langchain-strong-alliance)

- 究極のLangChain入門ガイド](https://zilliz.com/blog/langchain-ultimate-guide-getting-started)

- LangChainとZilliz CloudとMilvus 統合

よくあるLangChainの質問 (FAQ)

LangChainは何をするのですか?

LangChainは言語モデルによるアプリケーション開発を促進するために設計されたフレームワークです。LangChainは、アプリケーションのコンテキストを認識し、言語モデルを様々なコンテキストのソースに接続することで、より根拠のある応答を可能にします。さらに、LangChainは、提供されたコンテキストに基づいて情報に基づいた決定を行うために言語モデルを活用することによって、アプリケーションが効果的に推論できるようにします。

LangChainが解決する問題とは?

LangChainは、洗練された言語理解と推論機能を必要とするアプリケーション開発の課題を解決します。大規模な言語モデルとシームレスに統合し、コンテキストを認識できるフレームワークを提供することで、LangChainは開発者が自然言語入力を理解し、より効果的に応答できるアプリケーションを構築することを可能にします。

LLMとLangChainの違いは何ですか?

Large Language Model (LLM)が言語理解と生成機能にフォーカスしているのに対し、LangChainはアプリケーション内でのLLMの統合とオーケストレーションを可能にするフレームワークとして機能します。言い換えれば、LLMは言語処理能力を提供し、LangChainは様々なアプリケーションでこれらの能力を利用し活用するためのインフラとツールを提供します。

読み続けて

ラングチェーン・メモリーAI会話能力の強化

この記事では、LangChainモジュールを使ってメモリ・バッファを確立し、会話型AIアプリケーションを構築することで、最新のLLMのメモリ機能を探ります。

ラングチェーンツール先進のツールセットでAI開発に革命を起こす

LangChainツールは、AIで実現可能なことの境界を再定義する。

LangchainコミュニティAPIを探る:MilvusとZillizによるシームレスなベクターデータベース統合

この記事では、LangChain Community APIと、MilvusとZillizを統合して効率的なベクターデータベースのやり取りを実現する方法を紹介します。