Zilliz Cloudの新機能: 10倍のパフォーマンス向上とエンタープライズ機能の強化

ベクターデータベースは、より多くの企業がAIアプリケーションを本番稼動させるのに伴い、その勢いを増していますが、このシフトはパフォーマンス、スケール、管理に関する新たな課題をもたらします。本日リリースされたZilliz Cloudは、新しいCardinalベクトル検索エンジンとエンタープライズ対応の一連の機能により、これらの課題に正面から取り組みます。

カーディナルでパフォーマンスの壁を破る

Cardinalは、本番環境で10倍のパフォーマンス向上を実現する新しいベクトル検索エンジンで、このリリースの中核を成しています。これは単なるスピードの問題ではなく、ベクトル検索がどのようにスケールアップして機能すべきかを再考したものです。

CardinalはAutoIndexを導入し、データの特性とハードウェアの設定に基づいてインデックス構成を自動的に調整します。システムは最適な検索パフォーマンスを提供するために継続的に適応し、開発チームはインフラストラクチャを管理する代わりに機能の構築に集中することができます。

Cardinalは3層の最適化アプローチを採用しています。アルゴリズム層は、高度なIVFベースとグラフベースのアプローチを組み合わせ、フィルタリングされた結果であっても高い精度を維持します。エンジニアリング層は、実際のパフォーマンスを向上させるために、特殊なメモリ割り当てとマルチスレッディングを実装しています。最も低いレベルでは、x86およびARMプラットフォーム用のカーネル最適化により、標準的な実装と比較して最大3倍のスピードアップを実現しています。

エンタープライズ・スケールのためのプロダクション・レディ機能

ベクターデータベースがAIアプリケーションにとって重要なインフラとなる中、Zilliz Cloudのエンタープライズ向け機能を全面的に強化しました。

マルチレプリカのGA化

当社のマルチレプリカ機能が一般利用可能になり、レプリカを追加するにつれてリニアなQPS向上を提供します。トラフィックの多いアプリケーションでは、クエリが自動的にレプリカに分散され、レイテンシーが短縮され、効率が向上します。また、システムは可用性ゾーンにレプリカを分散させ、ゾーンの停止中であっても継続的な運用を保証します。

インフラの改善

パフォーマンスを最適化したコンピュート・ユニットのキャパシティを50%向上させ、CUあたり最大150万ベクトル(768次元)をサポートするようになりました。大規模な導入の場合、これは約30%のコスト削減につながります。

観測性の強化

Prometheus との統合により、システムメトリクスのリアルタイム監視が可能になりました。インフラストラクチャの健全性からデータ運用まで、26のメトリクスに41のアラートを実装しました。この包括的なモニタリングにより、チームはベクトル検索インフラをプロアクティブに管理することができます。

データ移行の簡素化

QdrantとPinecone Serverlessからの移行経路を追加し、成長するエコシステムをサポートします。Zilliz Cloudの強化された機能を利用しながら、移行プロセスでデータの整合性を維持できます。

認証とグローバルプレゼンス

電子メール、GitHub/Google認証、Oktaを介したエンタープライズSSOをサポートする新しいAuth0ベースの認証システムにより、セキュリティと利便性が融合しました。また、新たにAWS東京リージョンを追加し、世界12リージョンに拡大しました。

開発者エクスペリエンスの向上

技術的な改善だけでなく、開発者エクスペリエンスも一新しました。新しいウェブコンソールでは、可視化ツールが強化され、ワークフローが合理化されました。また、企業向けワークフローの請求サイクルの延長、自動化された通知、明細化された請求書による詳細なコストの可視化など、支払いシステムを刷新しました。

はじめに

これらの機能は、Zilliz Cloudのすべてのデプロイメントで利用可能です。無料トライアル(クレジットカード不要)、または30日間のエンタープライズトライアルをお試しください。どのクラウドマーケットプレイスからでもご契約いただけます。

詳細なドキュメントと移行ガイドについては、 ドキュメント をご覧ください。

DeepL.com(無料版)で翻訳しました。

読み続けて

Why Not All VectorDBs Are Agent-Ready

Explore why choosing the right vector database is critical for scaling AI agents, and why traditional solutions fall short in production.

Zilliz Cloud Introduces Advanced BYOC-I Solution for Ultimate Enterprise Data Sovereignty

Explore Zilliz Cloud BYOC-I, the solution that balances AI innovation with data control, enabling secure deployments in finance, healthcare, and education sectors.

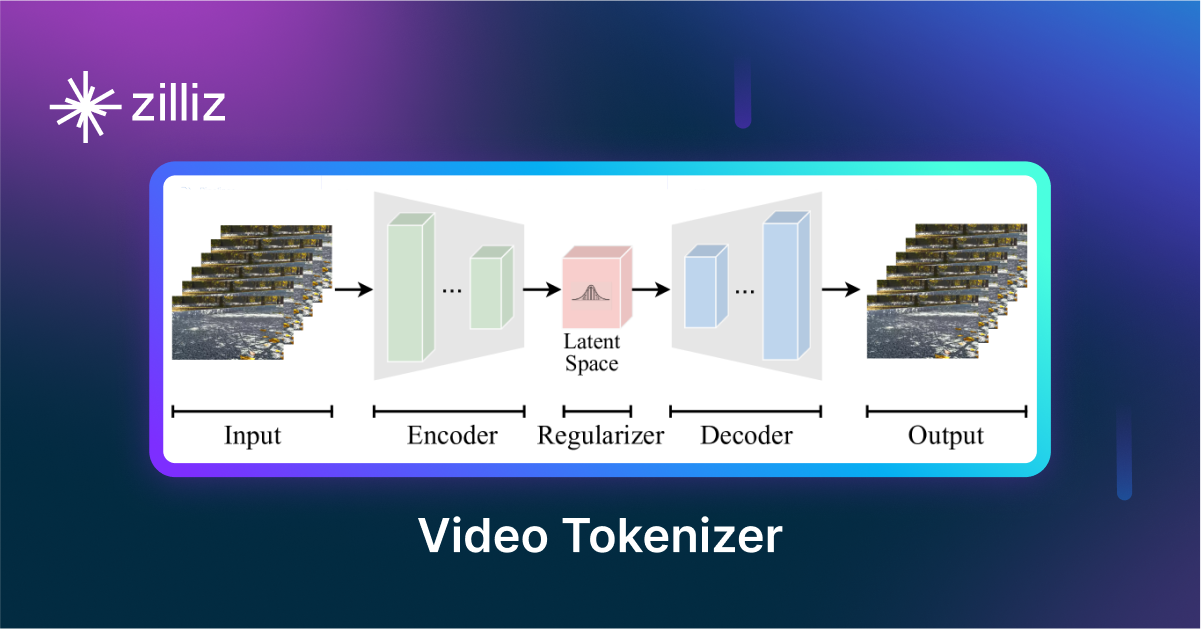

VidTok: Rethinking Video Processing with Compact Tokenization

VidTok tokenizes videos to reduce redundancy while preserving spatial and temporal details for efficient processing.