Генерация с усилением извлечения (RAG)

Ограничения LLM

Отсутствие информации по конкретной области

LLM обучаются исключительно на данных, которые находятся в открытом доступе. Таким образом, они могут не обладать знаниями о специфической для области, проприетарной или частной информации, которая не доступна для широкой публики.

Склонность к галлюцинациям

Языковые модели могут давать ответы только на основе имеющейся у них информации. Они могут предоставить неверную или вымышленную информацию, если у них недостаточно данных для ссылки.

Дорого и медленно

LLM взимают плату за каждый токен в запросах, что приводит к высоким затратам, особенно для повторяющихся вопросов. Кроме того, задержки ответов в часы пик также разочаровывают пользователей, ищущих быстрых ответов.

Неудача в доступе к актуальной информации

LLM часто обучаются на устаревших данных и не обновляют свою базу знаний регулярно из-за высоких затрат на обучение. Например, обучение GPT-3 может стоить до 1,4 миллиона долларов.

Лимит токенов

LLM устанавливают ограничение на количество токенов, которые можно добавить в запросы. Например, ChatGPT-3 имеет лимит в 4 096 токенов, в то время как GPT-4 (8K) имеет лимит токенов в 8 192.

Неизменяемые данные предварительного обучения

Данные предварительного обучения LLM могут содержать устаревшую или неверную информацию. К сожалению, такие данные нельзя изменить, исправить или удалить.

Как Zilliz Cloud улучшает приложения LLM

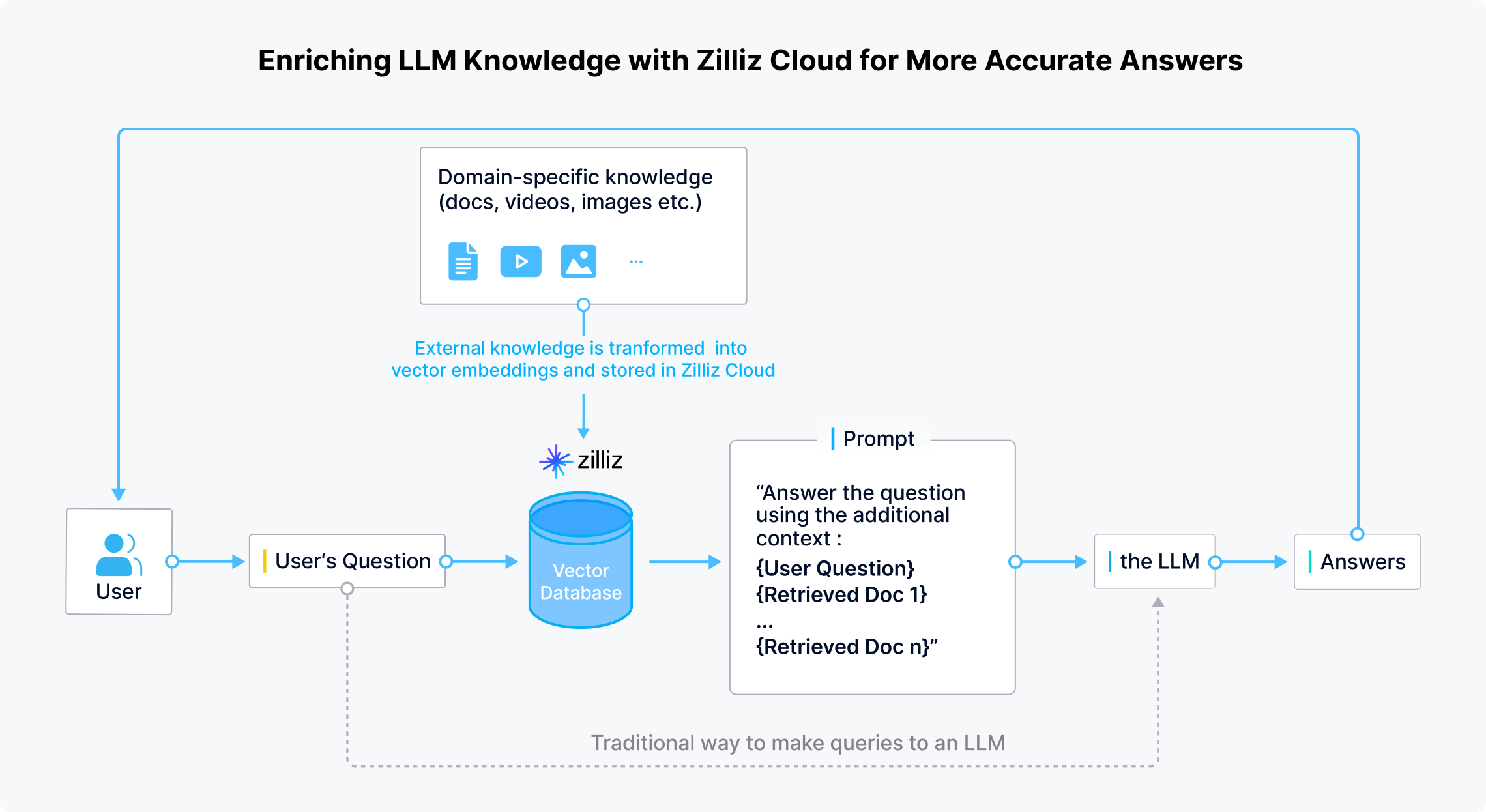

RAG для LLM: Обновление и расширение базы знаний LLM для более точных ответов

Zilliz Cloud позволяет разработчикам и предприятиям безопасно хранить специфичные для домена, актуальные и конфиденциальные частные данные вне LLM. Когда пользователь задает вопрос, приложения LLM используют модели встраивания для преобразования вопроса в векторы. Затем Zilliz Cloud проводит поиск по сходству, чтобы предоставить Top-K результатов, соответствующих этому вопросу. Наконец, эти результаты объединяются с исходным вопросом для создания подсказки, которая предоставляет всесторонний контекст для LLM, чтобы генерировать более точные ответы.

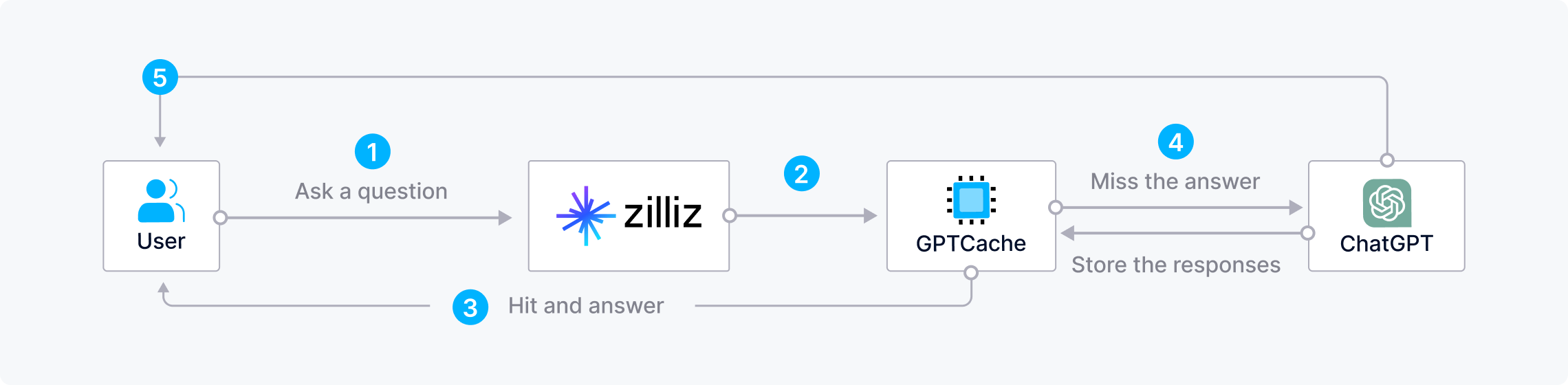

Экономия времени и затрат при объединении Zilliz Cloud с GPTCache

Частые запросы к LLM повторяющихся или похожих вопросов могут быть дорогостоящими, расточительными ресурсами и отнимать много времени, особенно в часы пик, когда ответы медленные. Чтобы сэкономить время и деньги при создании AI приложений, разработчики могут использовать Zilliz Cloud с GPTCache, открытым семантическим кешем, который хранит ответы LLM.При такой архитектуре Zilliz сначала проверяет GPTCache на наличие ответов, когда пользователь задает вопрос. Если ответ найден, Zilliz Cloud быстро возвращает его пользователю. В противном случае Zilliz Cloud отправляет запрос в LLM для получения ответа и сохраняет его в GPTCache для будущего использования.

Стек CVP

ChatGPT/LLM + векторная база данных + промпт-как-код

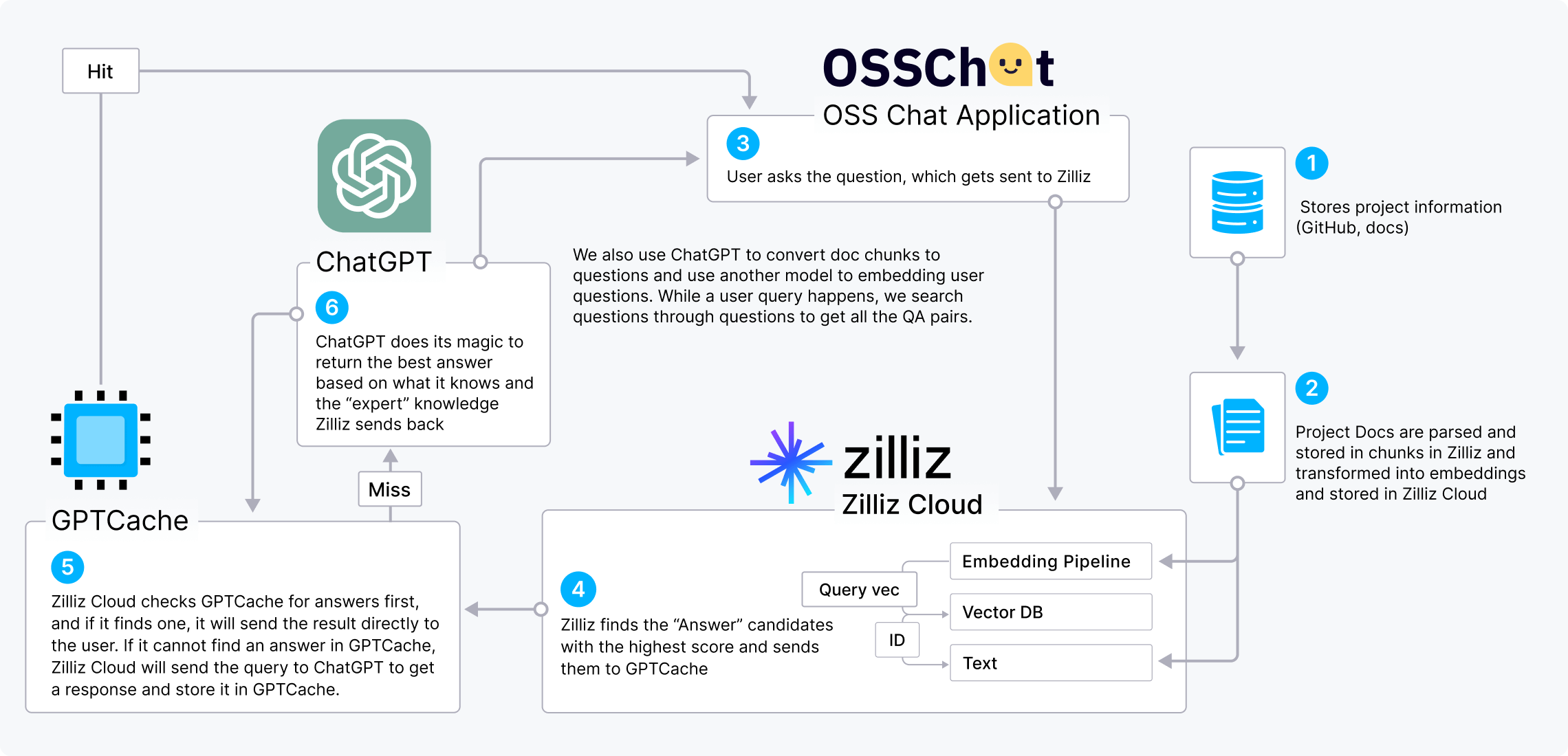

Стек CVP (ChatGPT/LLM + векторная база данных + промпт-как-код) — это все более популярный стек искусственного интеллекта, который демонстрирует ценность векторных баз данных для улучшения LLM. Мы можем использовать OSS Chat в качестве примера, чтобы продемонстрировать, как работает стек CVP.

OSS Chat — это чат-бот, который может отвечать на вопросы о проектах GitHub. Он собирает и хранит информацию из различных репозиториев GitHub и их страниц документации в Zilliz Cloud в виде эмбеддингов. Когда пользователь спрашивает OSS Chat о каком-либо проекте с открытым исходным кодом, Zilliz Cloud проводит поиск по сходству, чтобы найти topk наиболее релевантных результатов. Затем эти результаты объединяются с исходным вопросом для создания промпта, который дает ChatGPT более широкий контекст, что приводит к более точным ответам.

Мы также можем включить GPTCache в стек CVP, чтобы снизить затраты и ускорить ответы.

Проекты LLM с использованием Milvus и Zilliz Cloud

Узнайте, как разработчики используют Milvus и Zilliz Cloud для расширения возможностей своих генеративных AI приложений.

- OSS Chat

- PaperGPT

- NoticeAI

- Search.anything.io

- IkuStudies

- AssistLink AI

Интеграции Milvus с популярными проектами ИИ

OpenAI, LangChain, LlamaIndex, и многие другие пионеры ИИ интегрируются с Zilliz Cloud для усиления своих возможностей поиска.