Generación Aumentada por Recuperación (RAG)

Limitaciones de LLM

Falta de información específica del dominio

Los LLMs son entrenados únicamente con datos que están disponibles públicamente. Por lo tanto, pueden carecer de conocimiento sobre información específica del dominio, propietaria o privada que no es accesible al público.

Propenso a alucinaciones

Los LLMs solo pueden dar respuestas basadas en la información que tienen. Pueden proporcionar información incorrecta o fabricada si no tienen suficientes datos para referenciar.

Costoso y lento

Los LLMs cobran por cada token en las consultas, resultando en altos costos, particularmente para preguntas repetitivas. Además, los retrasos en las respuestas durante horas pico también frustran a los usuarios que buscan respuestas rápidas.

Incapacidad para acceder a información actualizada

Los LLMs a menudo son entrenados con datos desactualizados y no actualizan su base de conocimiento regularmente debido a los altos costos de entrenamiento. Por ejemplo, entrenar GPT-3 puede costar hasta 1.4 millones de dólares.

Límite de Tokens

Los LLMs establecen un límite en el número de tokens que se pueden añadir a los prompts de consulta. Por ejemplo, ChatGPT-3 tiene un límite de 4,096 tokens, mientras que GPT-4 (8K) tiene un límite de tokens de 8,192.

Datos de pre-entrenamiento inmutables

Los datos de pre-entrenamiento de los LLMs pueden contener información desactualizada o incorrecta. Desafortunadamente, tales datos no pueden ser modificados, corregidos o eliminados.

Cómo Zilliz Cloud Aumenta las Aplicaciones de LLM

RAG para LLMs: Actualizando y expandiendo la base de conocimiento de los LLMs para respuestas más precisas

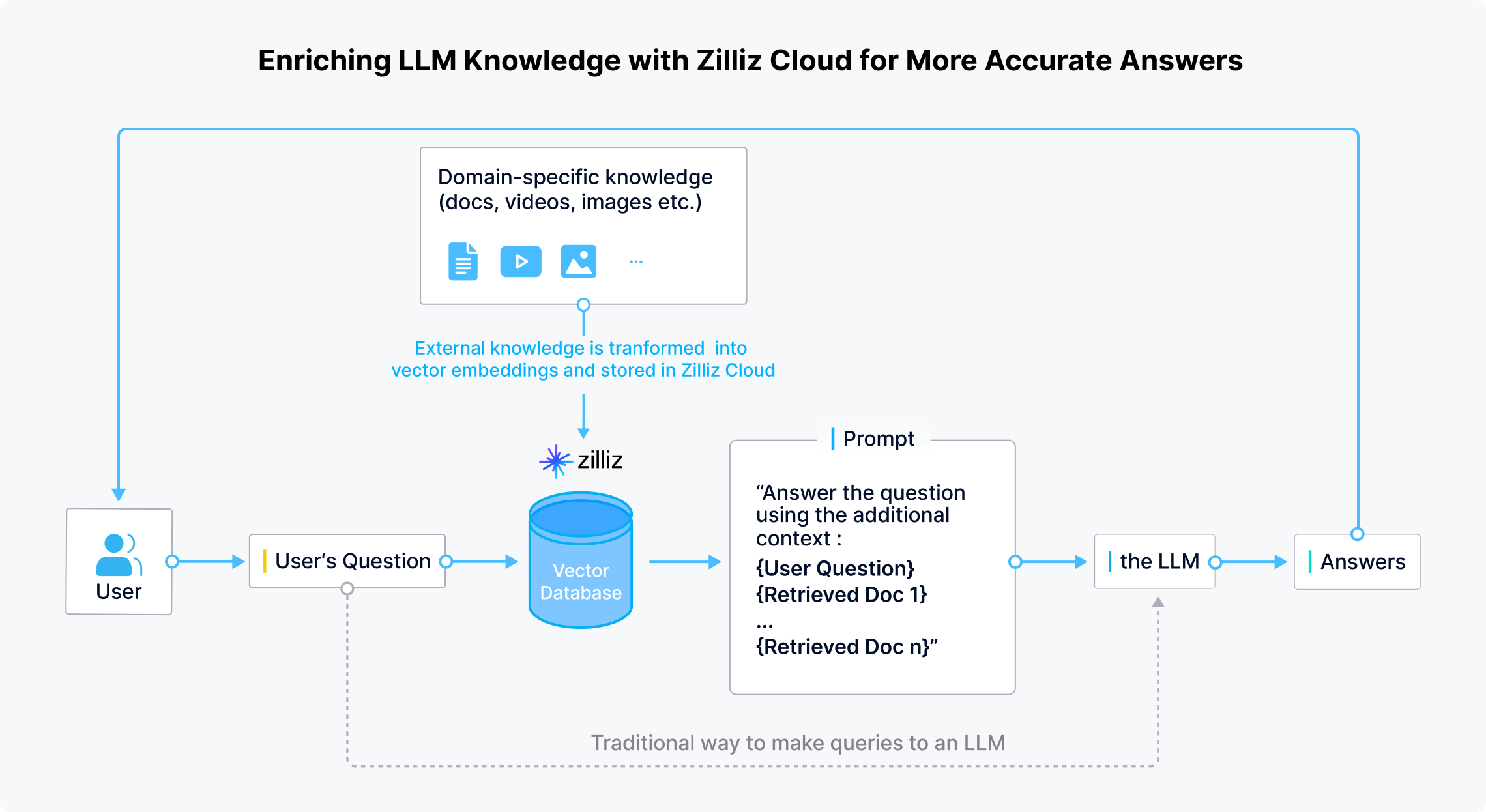

Zilliz Cloud permite a los desarrolladores y empresas almacenar de manera segura datos específicos del dominio, actualizados y confidenciales fuera de los LLMs. Cuando un usuario hace una pregunta, las aplicaciones de LLM usan modelos de embedding para transformar la pregunta en vectores. Zilliz Cloud luego realiza búsquedas de similitud para proporcionar los resultados Top-K relevantes a esa pregunta. Finalmente, estos resultados se combinan con la pregunta original para crear un prompt que proporciona un contexto completo para que el LLM genere respuestas más precisas.

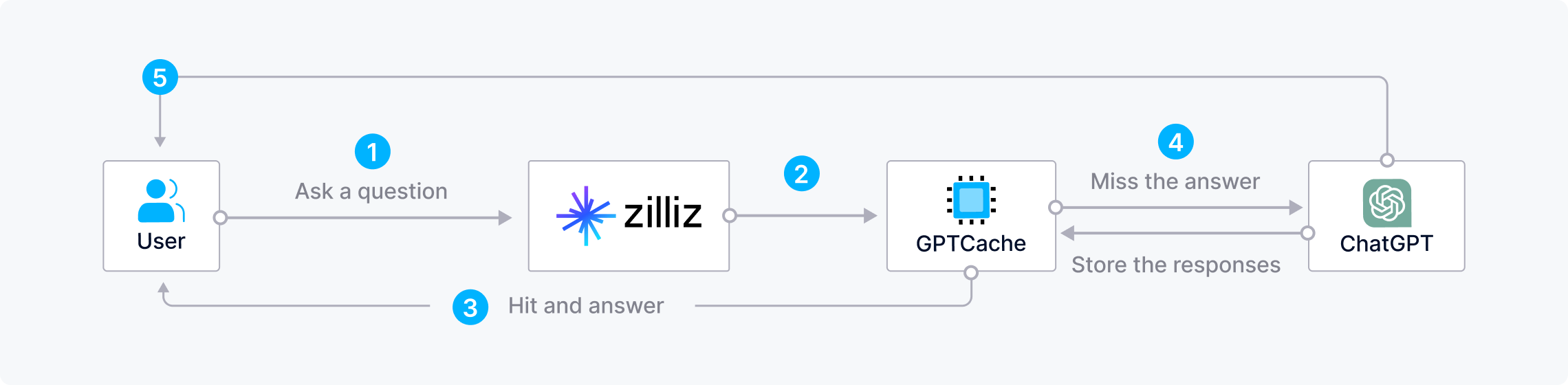

Ahorrando tiempo y costos al combinar Zilliz Cloud con GPTCache

Hacer preguntas repetitivas o similares a los LLMs con frecuencia puede ser costoso, derrochador de recursos y consumidor de tiempo, especialmente durante horas pico cuando las respuestas son lentas. Para ahorrar tiempo y dinero al construir aplicaciones de IA, los desarrolladores pueden utilizar Zilliz Cloud con GPTCache, un caché semántico de código abierto que almacena respuestas de LLM. Con esta arquitectura, Zilliz primero verifica GPTCache en busca de respuestas cuando un usuario hace una pregunta. Si encuentra una respuesta, Zilliz Cloud la devuelve rápidamente al usuario. De lo contrario, Zilliz Cloud envía la consulta al LLM para obtener una respuesta y la almacena en GPTCache para uso futuro.

La Pila CVP

ChatGPT/LLMs + una base de datos vectorial + prompt-as-code

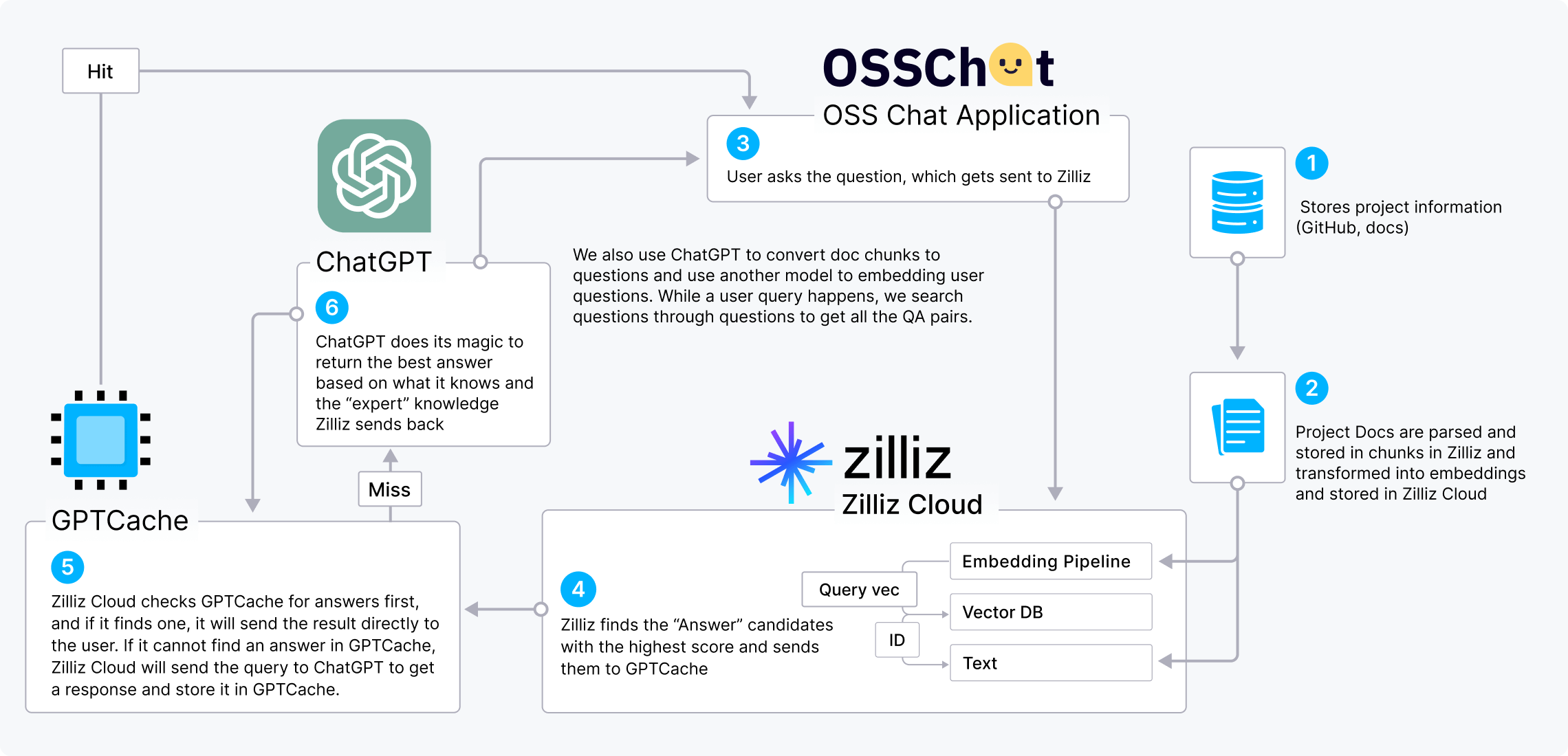

La pila CVP (ChatGPT/LLMs + una base de datos vectorial + prompt-as-code) es una pila de IA cada vez más popular que muestra el valor de las bases de datos vectoriales para el mejoramiento de LLM. Podemos usar OSS Chat como ejemplo para demostrar cómo funciona la pila CVP.

OSS Chat es un chatbot que puede responder preguntas sobre proyectos de GitHub. Recopila y almacena información de varios repositorios de GitHub y sus páginas de documentación en Zilliz Cloud en forma de embeddings. Cuando un usuario le pregunta a OSS Chat sobre cualquier proyecto de código abierto, Zilliz Cloud realiza una búsqueda de similitud para encontrar los topk resultados más relevantes. Luego, estos resultados se combinan con la pregunta original para crear un prompt que le da a ChatGPT un contexto más amplio, resultando en respuestas más precisas.

También podemos incorporar GPTCache en la pila CVP para reducir costos y acelerar las respuestas.

Proyectos de LLM que Utilizan Milvus & Zilliz Cloud

Aprende cómo los desarrolladores utilizan Milvus & Zilliz Cloud para potenciar sus aplicaciones de IA generativa.

- OSS Chat

- PaperGPT

- NoticeAI

- Search.anything.io

- IkuStudies

- AssistLink AI

Integraciones de Milvus con Proyectos Populares de IA

OpenAI, LangChain, LlamaIndex, y muchos otros pioneros de IA se están integrando con Zilliz Cloud para amplificar sus capacidades de recuperación.