Generazione Aumentata dalla Recupero (RAG)

Limitazioni degli LLM

Mancanza di informazioni specifiche del dominio

Gli LLM sono addestrati solo su dati pubblicamente disponibili. Pertanto, potrebbero mancare informazioni specifiche del dominio, proprietarie o private che non sono accessibili al pubblico.

Propensione alla creazione di allucinazioni

Gli LLM possono fornire solo risposte basate sui dati che possiedono. Potrebbero fornire informazioni errate o fabbricate se non hanno abbastanza dati a cui fare riferimento.

Costosi e lenti

Gli LLM addebitano una tariffa per ogni token nelle query, comportando costi elevati, in particolare per domande ripetitive. Inoltre, i ritardi nelle risposte durante i periodi di picco frustrano gli utenti che cercano risposte rapide.

Incapacità di accedere a informazioni aggiornate

Gli LLM sono spesso addestrati su dati obsoleti e non aggiornano regolarmente la loro base di conoscenze a causa degli elevati costi di addestramento. Ad esempio, l'addestramento di GPT-3 può costare fino a 1,4 milioni di dollari.

Limite di token

Gli LLM stabiliscono un limite sul numero di token che possono essere aggiunti alle richieste. Ad esempio, ChatGPT-3 ha un limite di 4.096 token, mentre GPT-4 (8K) ha un limite di token di 8.192.

Dati di pre-allenamento immutabili

I dati di pre-allenamento degli LLM possono contenere informazioni obsolete o errate. Purtroppo, tali dati non possono essere modificati, corretti o rimossi.

Come Zilliz Cloud Aumenta le Applicazioni LLM

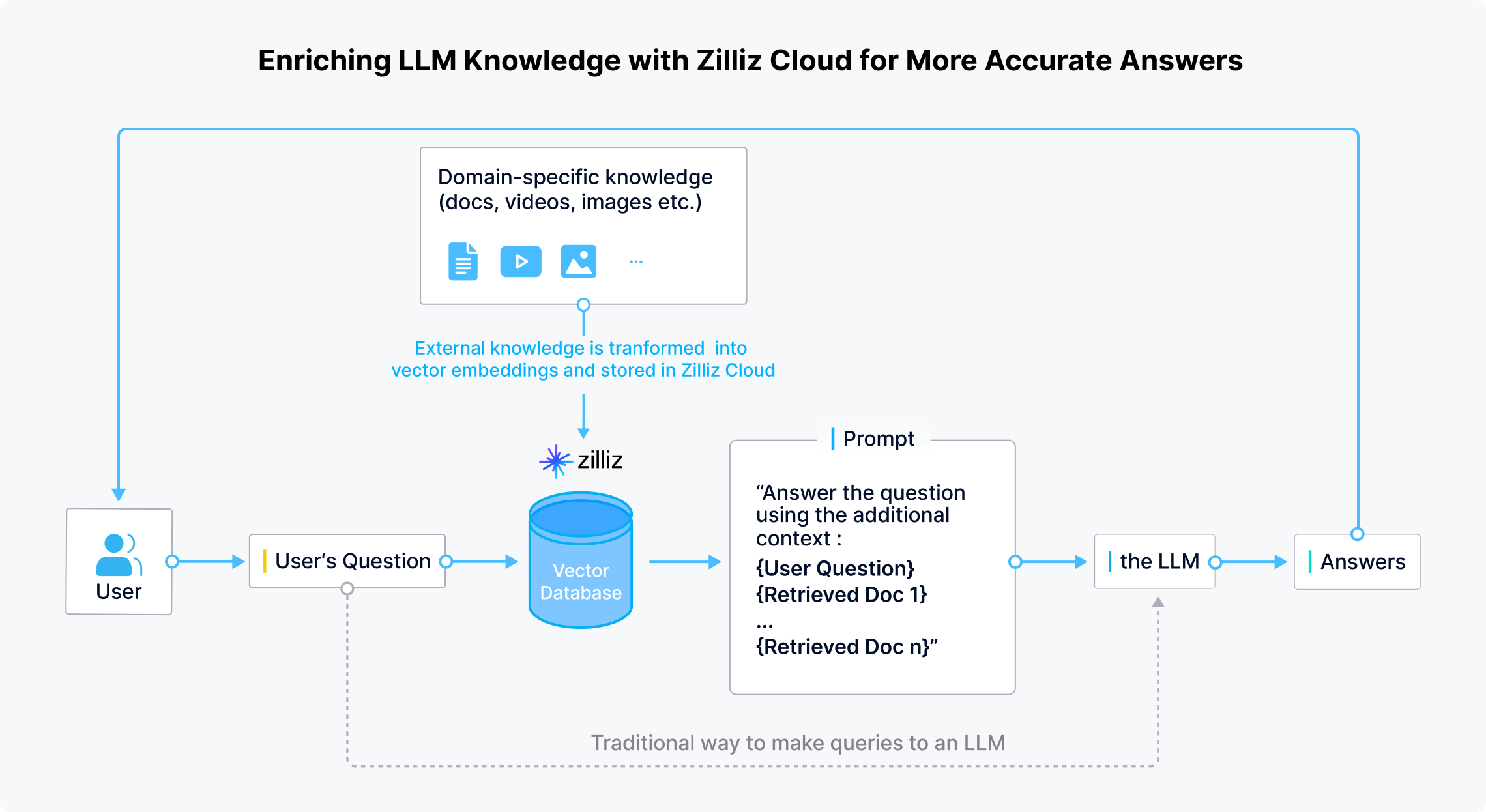

RAG per gli LLM: Aggiornamento ed espansione della base di conoscenze degli LLM per risposte più accurate

Zilliz Cloud consente a sviluppatori e aziende di archiviare in modo sicuro dati specifici del dominio, aggiornati e riservati al di fuori degli LLM. Quando un utente pone una domanda, le applicazioni LLM utilizzano modelli di embedding per trasformare la domanda in vettori. Zilliz Cloud esegue quindi una ricerca di similarità per fornire i risultati Top-K pertinenti a quella domanda. Infine, questi risultati vengono combinati con la domanda originale per creare un prompt che fornisca un contesto più ampio per generare risposte più accurate.

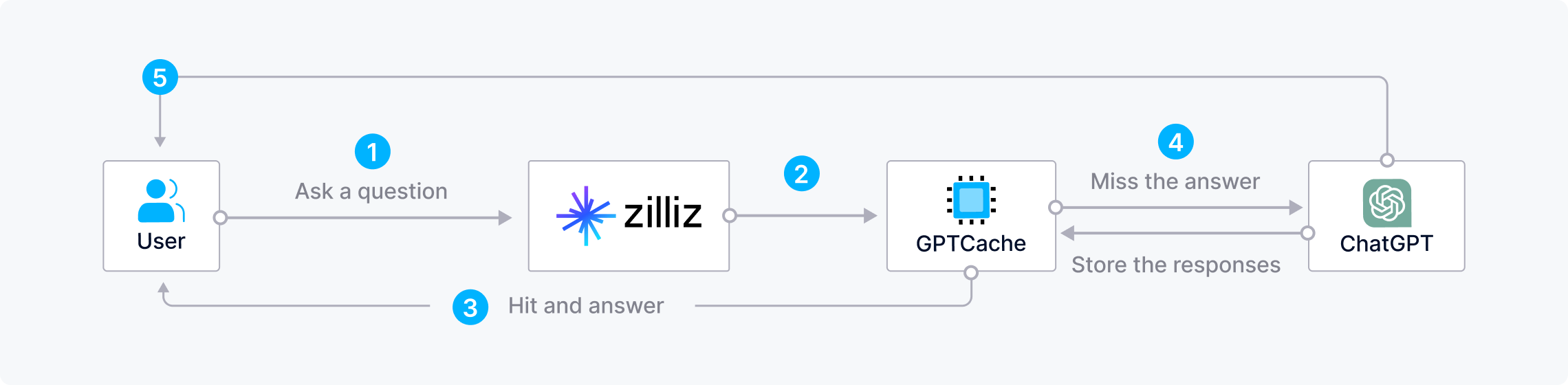

Risparmiare tempo e costi combinando Zilliz Cloud con GPTCache

Porre domande ripetitive o simili agli LLM può essere costoso, sprecando risorse e tempo, soprattutto durante i periodi di picco, quando le risposte sono lente. Per risparmiare tempo e denaro durante la costruzione di applicazioni AI, gli sviluppatori possono utilizzare Zilliz Cloud con GPTCache, una cache semantica open-source che memorizza le risposte degli LLM. Con questa architettura, Zilliz prima verifica GPTCache per risposte quando un utente fa una domanda. Se trova una risposta, Zilliz Cloud restituisce rapidamente la risposta all'utente. Altrimenti, Zilliz Cloud invia la query all'LLM per ottenere una risposta e la memorizza in GPTCache per un uso futuro.

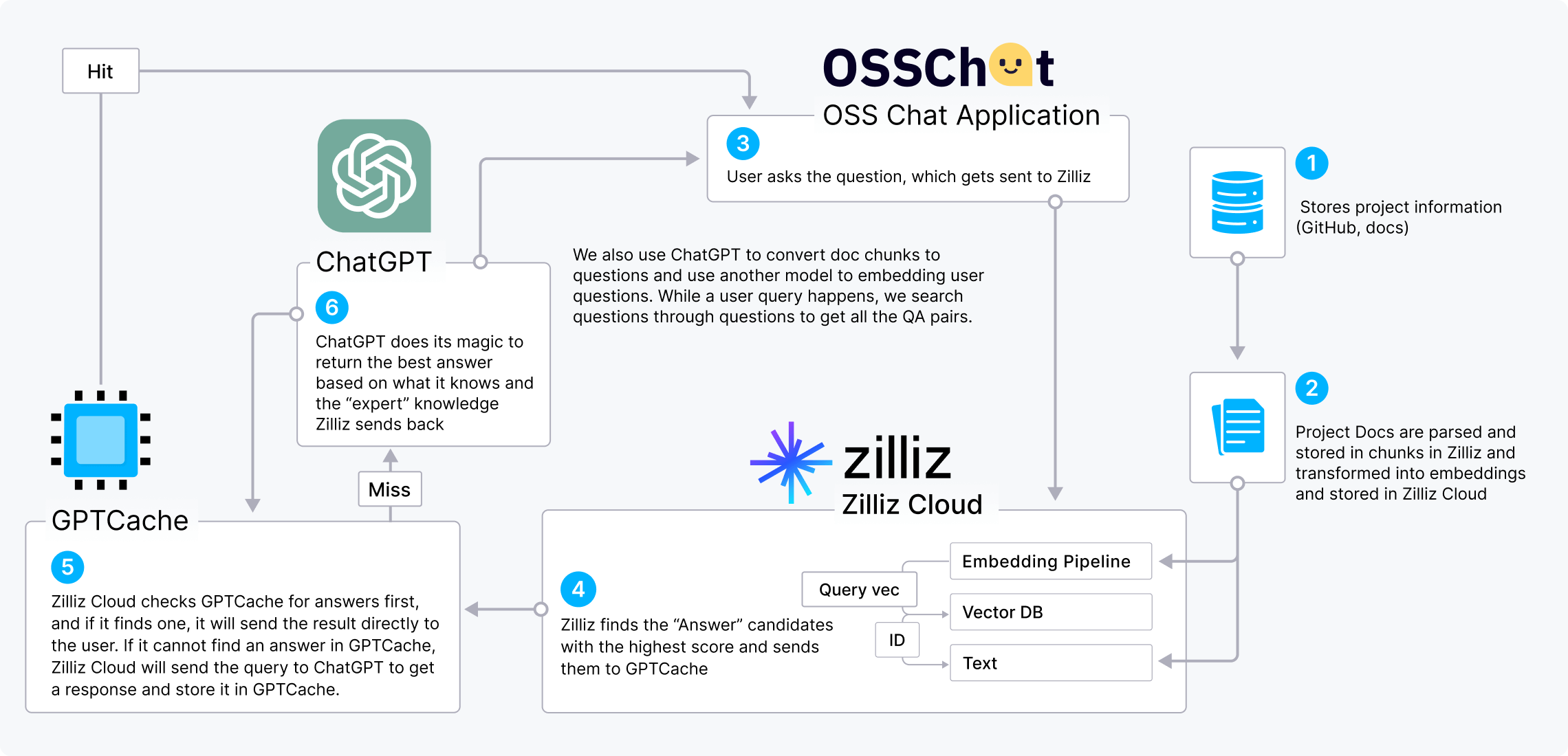

Il CVP Stack

ChatGPT/LLM + un database vettoriale + prompt-as-code

Il CVP stack (ChatGPT/LLM + un database vettoriale + prompt-as-code) è uno stack AI sempre più popolare che mostra il valore dei database vettoriali per il miglioramento degli LLM. Possiamo usare OSS Chat come esempio per dimostrare come funziona il CVP stack.

OSS Chat è un chatbot che può rispondere a domande su progetti GitHub. Raccoglie e archivia informazioni da vari repository GitHub e dalle loro pagine di documentazione in Zilliz Cloud sotto forma di embedding. Quando un utente chiede a OSS Chat informazioni su un progetto open-source, Zilliz Cloud esegue una ricerca di similarità per trovare i risultati più rilevanti. Questi risultati vengono poi combinati con la domanda originale per creare un prompt che fornisce a ChatGPT un contesto più ampio, portando a risposte più precise.

Possiamo anche incorporare GPTCache nel CVP stack per ridurre i costi e velocizzare le risposte.

Progetti LLM che utilizzano Milvus & Zilliz Cloud

Scopri come gli sviluppatori utilizzano Milvus e Zilliz Cloud per potenziare le loro applicazioni di AI generativa.

- OSS Chat

- PaperGPT

- NoticeAI

- Search.anything.io

- IkuStudies

- AssistLink AI

Integrazioni di Milvus con Progetti AI Popolari

OpenAI, LangChain, LlamaIndex e molti altri pionieri dell'AI si stanno integrando con Zilliz Cloud per amplificare le loro capacità di recupero.